Content from Warum einen Cluster verwenden?

Zuletzt aktualisiert am 2026-01-15 | Diese Seite bearbeiten

Übersicht

Fragen

- Warum sollte ich mich für High Performance Computing (HPC) interessieren?

- Was kann ich von diesem Kurs erwarten?

Ziele

- Beschreiben Sie, was ein HPC-System ist

- Ermitteln Sie, welchen Nutzen ein HPC-System für Sie haben könnte.

Häufig wachsen Forschungsprobleme, die mit Hilfe von Computern bearbeitet werden, über die Möglichkeiten des Desktop- oder Laptop-Computers hinaus, auf dem sie begonnen haben:

- Ein Statistikstudent möchte ein Modell kreuzvalidieren. Dazu muss das Modell 1000 Mal ausgeführt werden, aber jeder Durchlauf dauert eine Stunde. Die Ausführung des Modells auf einem Laptop würde über einen Monat dauern! Bei diesem Forschungsproblem werden die Endergebnisse berechnet, nachdem alle 1000 Modelle gelaufen sind, aber normalerweise wird immer nur ein Modell (in Serie) auf dem Laptop ausgeführt. Da jeder der 1000 Durchläufe unabhängig von den anderen ist, ist es theoretisch möglich, sie alle gleichzeitig (parallel) laufen zu lassen, wenn genügend Computer vorhanden sind.

- Ein Genomforscher hat bisher mit kleinen Datensätzen von Sequenzdaten gearbeitet, wird aber bald eine neue Art von Sequenzierungsdaten erhalten, die zehnmal so groß sind. Es ist bereits eine Herausforderung, die Datensätze auf einem Computer zu öffnen - die Analyse dieser größeren Datensätze wird ihn wahrscheinlich zum Absturz bringen. Bei diesem Forschungsproblem könnten die erforderlichen Berechnungen nicht parallelisiert werden, aber ein Computer mit mehr Speicher wäre erforderlich, um den viel größeren zukünftigen Datensatz zu analysieren.

- Ein Ingenieur verwendet ein Strömungsdynamik-Paket, das über eine Option zur parallelen Ausführung verfügt. Bislang wurde diese Option auf einem Desktop nicht genutzt. Bei der Umstellung von 2D- auf 3D-Simulationen hat sich die Simulationszeit mehr als verdreifacht. Es könnte nützlich sein, diese Option oder Funktion zu nutzen. Bei diesem Forschungsproblem sind die Berechnungen in jeder Region der Simulation weitgehend unabhängig von den Berechnungen in anderen Regionen der Simulation. Es ist möglich, die Berechnungen in jeder Region gleichzeitig (parallel) auszuführen, ausgewählte Ergebnisse je nach Bedarf an benachbarte Regionen weiterzugeben und die Berechnungen zu wiederholen, um zu einem endgültigen Satz von Ergebnissen zu konvergieren. Beim Übergang von einem 2D- zu einem 3D-Modell nimmt sowohl die Datenmenge als auch die Menge der Berechnungen stark zu, und es ist theoretisch möglich, die Berechnungen auf mehrere Computer zu verteilen, die über ein gemeinsames Netzwerk kommunizieren.

In all diesen Fällen ist der Zugang zu mehr (und größeren) Computern erforderlich. Diese Rechner sollten gleichzeitig nutzbar sein, um parallel die Probleme vieler Forscher zu lösen.

Jargon Busting Präsentation

Öffnen Sie den HPC Jargon Buster in

einer neuen Registerkarte. Um den Inhalt zu präsentieren, drücken Sie

C, um eine clone in einem separaten

Fenster zu öffnen, und drücken Sie dann P, um den

Darstellungsmodus (presentation) umzuschalten.

Ich habe noch nie einen Server benutzt, oder?

Nehmen Sie sich eine Minute Zeit und überlegen Sie, für welche Ihrer täglichen Interaktionen mit einem Computer Sie möglicherweise einen entfernten Server oder sogar einen Cluster benötigen, um Ergebnisse zu erhalten.

- Abrufen von E-Mails: Ihr Computer (möglicherweise in Ihrer Hosentasche) kontaktiert einen entfernten Rechner, authentifiziert sich und lädt eine Liste neuer Nachrichten herunter; außerdem werden Änderungen des Nachrichtenstatus hochgeladen, z. B. ob Sie die Nachricht gelesen, als Junk markiert oder gelöscht haben. Da Ihr Konto nicht das einzige ist, ist der Mailserver wahrscheinlich einer von vielen in einem Rechenzentrum.

- Bei der Online-Suche nach einem Begriff wird der Suchbegriff mit einer umfangreichen Datenbank aller bekannten Websites verglichen und nach Übereinstimmungen gesucht. Diese “Abfrage” kann ganz einfach sein, aber der Aufbau dieser Datenbank ist eine monumentale Aufgabe! Bei jedem Schritt sind Server beteiligt.

- Bei der Suche nach einer Wegbeschreibung auf einer Karten-Website werden (A) Start- und (B) Endpunkt durch Durchqueren eines Graphen verbunden, um den “kürzesten” Weg nach Entfernung, Zeit, Kosten oder einer anderen Metrik zu finden. Die Umwandlung einer Karte in die richtige Form ist relativ einfach, aber die Berechnung aller möglichen Routen zwischen A und B ist aufwendig.

Das Abrufen von E-Mails könnte seriell sein: Ihr Rechner verbindet sich mit einem Server und tauscht Daten aus. Eine Suche durch Abfrage der Datenbank nach Ihrem Suchbegriff (oder Endpunkten) könnte ebenfalls seriell sein, da ein Rechner Ihre Anfrage erhält und das Ergebnis zurückgibt. Das Zusammenstellen und Speichern der gesamten Datenbank übersteigt jedoch bei weitem die Möglichkeiten eines einzelnen Rechners. Daher werden diese Funktionen parallel von einer großen, “hyperscale” Sammlung von Servern ausgeführt, die zusammenarbeiten.

- Beim High Performance Computing (HPC) wird in der Regel eine Verbindung zu sehr großen Rechensystemen an anderen Orten der Welt hergestellt.

- Diese anderen Systeme können für Arbeiten verwendet werden, die auf kleineren Systemen entweder unmöglich oder sehr viel langsamer wären.

- HPC-Ressourcen werden von mehreren Benutzern gemeinsam genutzt.

- Die Standardmethode zur Interaktion mit solchen Systemen erfolgt über eine Befehlszeilenschnittstelle.

Content from Verbinden mit einem entfernten HPC-System

Zuletzt aktualisiert am 2026-01-15 | Diese Seite bearbeiten

Übersicht

Fragen

- Wie melde ich mich bei einem entfernten HPC-System an?

Ziele

- Konfigurieren Sie den sicheren Zugriff auf ein entferntes HPC-System.

- Verbinden Sie sich mit einem entfernten HPC-System.

Sichere Verbindungen

Der erste Schritt bei der Nutzung eines Clusters besteht darin, eine Verbindung von unserem Laptop zum Cluster herzustellen. Wenn wir an einem Computer sitzen (oder stehen oder ihn in der Hand oder am Handgelenk halten), erwarten wir eine visuelle Anzeige mit Symbolen, Widgets und vielleicht einigen Fenstern oder Anwendungen: eine grafische Benutzeroberfläche, oder GUI. Da es sich bei Computerclustern um entfernte Ressourcen handelt, mit denen wir uns über langsame oder unregelmäßige Schnittstellen (insbesondere WiFi und VPNs) verbinden, ist es praktischer, eine Befehlszeilenschnittstelle (CLI) zu verwenden, um Befehle im Klartext zu senden. Wenn ein Befehl eine Ausgabe zurückgibt, wird diese ebenfalls im Klartext ausgedruckt. Die Befehle, die wir heute ausführen, werden kein Fenster öffnen, um die Ergebnisse grafisch darzustellen.

Wenn Sie jemals die Windows-Eingabeaufforderung oder das macOS-Terminal geöffnet haben, haben Sie eine CLI gesehen. Wenn Sie bereits an den The Carpentries-Kursen über die UNIX-Shell oder Versionskontrolle teilgenommen haben, haben Sie die CLI auf Ihrem lokalen Rechner ausgiebig genutzt. Der einzige Sprung, den Sie hier machen müssen, ist das Öffnen einer CLI auf einem entfernten Rechner, wobei Sie einige Vorsichtsmaßnahmen treffen müssen, damit andere Leute im Netzwerk die Befehle, die Sie ausführen, oder die Ergebnisse, die der entfernte Rechner zurückschickt, nicht sehen (oder ändern) können. Wir werden das Secure SHell-Protokoll (oder SSH) verwenden, um eine verschlüsselte Netzwerkverbindung zwischen zwei Rechnern zu öffnen, die es Ihnen ermöglicht, Text und Daten zu senden und zu empfangen, ohne sich um neugierige Blicke sorgen zu müssen.

SSH-Clients sind in der Regel Kommandozeilenprogramme, bei denen Sie

als einziges Argument die Adresse des entfernten Rechners angeben

müssen. Wenn sich Ihr Benutzername auf dem entfernten System von dem

unterscheidet, den Sie lokal verwenden, müssen Sie auch diesen angeben.

Wenn Ihr SSH-Client über eine grafische Oberfläche verfügt, wie z. B.

PuTTY oder MobaXterm, geben Sie diese Argumente an, bevor Sie auf

“Verbinden” klicken Im Terminal schreiben Sie etwas wie

ssh userName@hostname, wobei das Argument wie eine

E-Mail-Adresse ist: das “@”-Symbol wird verwendet, um die persönliche ID

von der Adresse des entfernten Rechners zu trennen.

Bei der Anmeldung an einem Laptop, Tablet oder einem anderen

persönlichen Gerät sind normalerweise ein Benutzername, ein Kennwort

oder ein Muster erforderlich, um unbefugten Zugriff zu verhindern. In

diesen Situationen ist die Wahrscheinlichkeit, dass jemand anderes Ihr

Passwort abfängt, gering, da die Aufzeichnung Ihrer Tastenanschläge

einen böswilligen Exploit oder physischen Zugang erfordert. Bei Systemen

wie login1, auf denen ein SSH-Server läuft, kann sich jeder

im Netzwerk anmelden oder dies versuchen. Da Benutzernamen oft

öffentlich oder leicht zu erraten sind, ist Ihr Passwort oft das

schwächste Glied in der Sicherheitskette. Viele Cluster verbieten daher

die passwortbasierte Anmeldung und verlangen stattdessen, dass Sie ein

öffentlich-privates Schlüsselpaar mit einem viel stärkeren Passwort

erzeugen und konfigurieren. Auch wenn Ihr Cluster dies nicht

vorschreibt, wird der nächste Abschnitt Sie durch die Verwendung von

SSH-Schlüsseln und eines SSH-Agenten führen, um sowohl Ihre Sicherheit

zu erhöhen als auch die Anmeldung bei entfernten Systemen zu

erleichtern.

Bessere Sicherheit mit SSH-Schlüsseln

Die Lesson Setup enthält Anweisungen für die Installation einer Shell-Anwendung mit SSH. Falls Sie dies noch nicht getan haben, öffnen Sie bitte diese Shell-Anwendung mit einer Unix-ähnlichen Kommandozeilenschnittstelle auf Ihrem System.

SSH-Schlüssel sind eine alternative Methode zur Authentifizierung, um Zugang zu entfernten Computersystemen zu erhalten. Sie können auch zur Authentifizierung bei der Übertragung von Dateien oder für den Zugriff auf entfernte Versionskontrollsysteme (wie GitHub) verwendet werden. In diesem Abschnitt werden Sie ein Paar SSH-Schlüssel erstellen:

- ein privater Schlüssel, den Sie auf Ihrem eigenen Computer aufbewahren, und

- ein öffentlicher Schlüssel, der auf jedem entfernten System platziert werden kann, auf das Sie zugreifen wollen.

Private Schlüssel sind Ihr sicherer digitaler Reisepass

Ein privater Schlüssel, der für jeden außer Ihnen sichtbar ist, sollte als kompromittiert betrachtet werden und muss vernichtet werden. Dazu gehören unzulässige Rechte für das Verzeichnis, in dem er (oder eine Kopie) gespeichert ist, das Durchqueren eines nicht sicheren (verschlüsselten) Netzwerks, der Anhang einer unverschlüsselten E-Mail und sogar die Anzeige des Schlüssels in Ihrem Terminalfenster.

Schützen Sie diesen Schlüssel, als ob er Ihre Haustür aufschließen würde. In vielerlei Hinsicht tut er das auch.

Unabhängig von der Software oder dem Betriebssystem, das Sie verwenden, bitte wählen Sie ein starkes Passwort oder eine Passphrase, um Ihren privaten SSH-Schlüssel zusätzlich zu schützen.

Überlegungen zu SSH-Schlüsselpasswörtern

Wenn Sie dazu aufgefordert werden, geben Sie ein sicheres Passwort ein, das Sie sich merken können. Hierfür gibt es zwei gängige Ansätze:

- Erstellen Sie eine einprägsame Passphrase mit einigen Interpunktionszeichen und Buchstaben-Zahlen-Ersetzungen, 32 Zeichen oder länger. Straßenadressen eignen sich gut; seien Sie jedoch vorsichtig mit Social-Engineering- oder Public-Records-Angriffen.

- Verwenden Sie einen Passwort-Manager und seinen eingebauten Passwort-Generator mit allen Zeichenklassen, 25 Zeichen oder länger. KeePass und BitWarden sind zwei gute Optionen.

- Nichts ist weniger sicher als ein privater Schlüssel ohne Passwort. Wenn Sie die Passworteingabe versehentlich übersprungen haben, gehen Sie zurück und erzeugen Sie ein neues Schlüsselpaar mit einem starken Passwort.

SSH-Schlüssel auf Linux, Mac, MobaXterm und Windows Subsystem für Linux

Sobald Sie ein Terminal geöffnet haben, prüfen Sie, ob bereits SSH-Schlüssel und Dateinamen vorhanden sind, da vorhandene SSH-Schlüssel überschrieben werden.

Wenn ~/.ssh/id_ed25519 bereits existiert, müssen Sie

einen anderen Namen für das neue Schlüsselpaar angeben.

Erzeugen Sie ein neues Schlüsselpaar aus öffentlichem und privatem

Schlüssel mit dem folgenden Befehl, der einen stärkeren Schlüssel als

den Standardschlüssel ssh-keygen erzeugt, indem Sie diese

Flags aufrufen:

-

-a(Standardwert ist 16): Anzahl der Runden der Passphrasenableitung; erhöhen Sie diese, um Brute-Force-Angriffe zu verlangsamen. -

-t(Standard ist rsa): Geben Sie den “Typ” oder kryptographischen Algorithmus an.ed25519spezifiziert EdDSA mit einem 256-Bit-Schlüssel; er ist schneller als RSA mit einer vergleichbaren Stärke. -

-f(Standard ist /home/user/.ssh/id_algorithm): Dateiname zum Speichern Ihres privaten Schlüssels. Der Dateiname des öffentlichen Schlüssels ist identisch, mit der Erweiterung.pub.

Wenn Sie dazu aufgefordert werden, geben Sie ein sicheres Passwort ein, das die obigen Überlegungen berücksichtigt. Beachten Sie, dass sich das Terminal nicht zu ändern scheint, während Sie das Passwort eingeben: Das ist zu Ihrer Sicherheit so gewollt. Sie werden aufgefordert, es noch einmal einzugeben, also machen Sie sich nicht zu viele Gedanken über Tippfehler.

Werfen Sie einen Blick in ~/.ssh (verwenden Sie

ls ~/.ssh). Sie sollten zwei neue Dateien sehen:

- Ihr privater Schlüssel (

~/.ssh/id_ed25519): do not share with anyone! - den gemeinsam nutzbaren öffentlichen Schlüssel

(

~/.ssh/id_ed25519.pub): Wenn ein Systemadministrator nach einem Schlüssel fragt, ist dies der Schlüssel, den Sie senden müssen. Es ist auch sicher, ihn auf Websites wie GitHub hochzuladen: Er ist dafür gedacht, gesehen zu werden.

Verwenden Sie RSA für ältere Systeme

Wenn die Schlüsselerzeugung fehlgeschlagen ist, weil ed25519 nicht verfügbar ist, versuchen Sie es mit dem älteren (aber immer noch starken und vertrauenswürdigen) RSA Kryptosystem. Prüfen Sie auch hier zunächst, ob ein Schlüssel vorhanden ist:

Wenn ~/.ssh/id_rsa bereits existiert, müssen Sie einen

anderen Namen für das neue Schlüsselpaar wählen. Erzeugen Sie es wie

oben, mit den folgenden zusätzlichen Flags:

-

-blegt die Anzahl der Bits des Schlüssels fest. Die Vorgabe ist 2048. EdDSA verwendet eine feste Schlüssellänge, so dass dieses Flag keine Auswirkung haben würde. -

-o(kein Standard): Verwenden Sie das OpenSSH-Schlüsselformat, anstatt PEM.

Wenn Sie dazu aufgefordert werden, geben Sie ein sicheres Passwort ein und beachten Sie dabei die oben genannten Überlegungen.

Werfen Sie einen Blick in ~/.ssh (verwenden Sie

ls ~/.ssh). Sie sollten zwei neue Dateien sehen:

- Ihr privater Schlüssel (

~/.ssh/id_rsa): do not share with anyone! - den gemeinsam nutzbaren öffentlichen Schlüssel

(

~/.ssh/id_rsa.pub): Wenn ein Systemadministrator nach einem Schlüssel fragt, ist dies der Schlüssel, den Sie senden müssen. Es ist auch sicher, ihn auf Websites wie GitHub hochzuladen: Er ist dafür gedacht, gesehen zu werden.

SSH-Schlüssel auf PuTTY

Wenn Sie PuTTY unter Windows verwenden, laden Sie

puttygen herunter und verwenden Sie es, um das

Schlüsselpaar zu erzeugen. Siehe die PuTTY-Dokumentation

für Details.

- Wählen Sie

EdDSAals Schlüsseltyp. - Wählen Sie

255als Schlüsselgröße oder -stärke. - Klicken Sie auf die Schaltfläche “Generate”.

- Sie müssen keinen Kommentar eingeben.

- Wenn Sie dazu aufgefordert werden, geben Sie ein sicheres Passwort ein und beachten Sie dabei die oben genannten Überlegungen.

- Speichern Sie die Schlüssel in einem Ordner, den kein anderer Benutzer des Systems lesen kann.

Werfen Sie einen Blick in den von Ihnen angegebenen Ordner. Sie sollten zwei neue Dateien sehen:

- Ihr privater Schlüssel (

id_ed25519): do not share with anyone! - den gemeinsam nutzbaren öffentlichen Schlüssel

(

id_ed25519.pub): Wenn ein Systemadministrator nach einem Schlüssel fragt, ist dies der Schlüssel, den Sie senden müssen. Es ist auch sicher, ihn auf Websites wie GitHub hochzuladen: Er ist dafür gedacht, gesehen zu werden.

SSH Agent für einfachere Schlüsselverwaltung

Ein SSH-Schlüssel ist nur so stark wie das Passwort, mit dem er entsperrt wird. Andererseits ist es mühsam, jedes Mal ein komplexes Passwort einzugeben, wenn man sich mit einem Rechner verbindet, und wird schnell langweilig. An dieser Stelle kommt der SSH-Agent ins Spiel.

Wenn Sie einen SSH-Agenten verwenden, können Sie Ihr Passwort für den privaten Schlüssel einmal eingeben und dann den Agenten veranlassen, es für eine bestimmte Anzahl von Stunden oder bis zu Ihrer Abmeldung zu speichern. Solange kein böswilliger Akteur physischen Zugang zu Ihrem Rechner hat, ist das Kennwort auf diese Weise sicher, und Sie müssen das Kennwort nicht mehrmals eingeben.

Merken Sie sich Ihr Passwort, denn sobald es im Agenten abläuft, müssen Sie es erneut eingeben.

SSH-Agenten auf Linux, macOS und Windows

Öffnen Sie Ihr Terminalprogramm und prüfen Sie, ob ein Agent läuft:

-

Wenn Sie eine Fehlermeldung wie diese erhalten,

FEHLER

Error connecting to agent: No such file or directory… dann müssen Sie den Agenten wie folgt starten:

WichtigWas ist in einem

$(...)?Die Syntax dieses SSH-Agent-Befehls ist ungewöhnlich, basierend auf dem, was wir in der UNIX-Shell-Lektion gesehen haben. Das liegt daran, dass der

ssh-agent-Befehl eine Verbindung öffnet, auf die nur Sie Zugriff haben, und eine Reihe von Shell-Befehlen ausgibt, die verwendet werden können, um sie zu erreichen - aber sie werden nicht ausgeführt!AUSGABE

SSH_AUTH_SOCK=/tmp/ssh-Zvvga2Y8kQZN/agent.131521; export SSH_AUTH_SOCK; SSH_AGENT_PID=131522; export SSH_AGENT_PID; echo Agent pid 131522;Der Befehl

evalinterpretiert diese Textausgabe als Befehle und ermöglicht Ihnen den Zugriff auf die gerade erstellte SSH-Agent-Verbindung.Sie könnten jede Zeile der

ssh-agent-Ausgabe selbst ausführen und das gleiche Ergebnis erzielen. Die Verwendung vonevalmacht dies nur einfacher. Andernfalls läuft Ihr Agent bereits: Lassen Sie ihn in Ruhe.

Fügen Sie Ihren Schlüssel zum Agenten hinzu, wobei die Sitzung nach 8 Stunden abläuft:

AUSGABE

Enter passphrase for .ssh/id_ed25519:

Identity added: .ssh/id_ed25519

Lifetime set to 86400 secondsWährend der Dauer (8 Stunden) wird der SSH-Agent bei jeder Verwendung dieses Schlüssels den Schlüssel für Sie bereitstellen, ohne dass Sie einen einzigen Tastendruck eingeben müssen.

SSH-Agent auf PuTTY

Wenn Sie PuTTY unter Windows verwenden, laden Sie

pageant herunter und verwenden Sie es als SSH-Agent. Siehe

die PuTTY-Dokumentation.

Einloggen in den Cluster

Öffnen Sie Ihr Terminal oder Ihren grafischen SSH-Client und melden

Sie sich beim Cluster an. Ersetzen Sie yourUsername durch

Ihren Benutzernamen oder den von den Lehrkräften angegebenen.

Sie werden möglicherweise nach Ihrem Passwort gefragt. Achtung: Die

Zeichen, die Sie nach der Passwortabfrage eingeben, werden nicht auf dem

Bildschirm angezeigt. Die normale Ausgabe wird fortgesetzt, sobald Sie

Enter drücken.

Sie haben vielleicht bemerkt, dass sich die Eingabeaufforderung

geändert hat, als Sie sich mit dem Terminal beim entfernten System

angemeldet haben (wenn Sie sich mit PuTTY angemeldet haben, gilt dies

nicht, da PuTTY kein lokales Terminal anbietet). Diese Änderung ist

wichtig, weil sie Ihnen helfen kann, zu unterscheiden, auf welchem

System die von Ihnen eingegebenen Befehle ausgeführt werden, wenn Sie

sie an das Terminal übergeben. Diese Änderung ist auch eine kleine

Komplikation, mit der wir uns im Laufe des Workshops auseinandersetzen

müssen. Was genau als Eingabeaufforderung (die üblicherweise mit

$ endet) im Terminal angezeigt wird, wenn es mit dem

lokalen System und dem entfernten System verbunden ist, wird

normalerweise für jeden Benutzer unterschiedlich sein. Wir müssen aber

trotzdem angeben, auf welchem System wir Befehle eingeben, also werden

wir die folgende Konvention anwenden:

-

[you@laptop:~]$, wenn der Befehl auf einem Terminal eingegeben werden soll, das mit Ihrem lokalen Computer verbunden ist -

[yourUsername@login1 ~], wenn der Befehl auf einem Terminal eingegeben werden soll, das mit dem entfernten System verbunden ist -

$, wenn es wirklich keine Rolle spielt, mit welchem System das Terminal verbunden ist.

Schauen Sie sich in Ihrem Remote Home um

Sehr oft sind viele Benutzer versucht, sich eine

Hochleistungsrechner-Installation als eine riesige, magische Maschine

vorzustellen. Manchmal nehmen sie an, dass der Computer, an dem sie sich

angemeldet haben, der gesamte Computer-Cluster ist. Was passiert also

wirklich? Bei welchem Computer haben wir uns angemeldet? Der Name des

aktuellen Computers, auf dem wir angemeldet sind, kann mit dem Befehl

hostname überprüft werden. (Vielleicht bemerken Sie auch,

dass der aktuelle Hostname auch Teil unserer Eingabeaufforderung

ist)

AUSGABE

login1Wir befinden uns also definitiv auf dem entfernten Rechner. Als

Nächstes wollen wir herausfinden, wo wir uns befinden, indem wir

pwd ausführen, um das Arbeitsverzeichnis (print working

directory) auszugeben.

AUSGABE

/home/yourUsernameGroßartig, wir wissen, wo wir sind! Schauen wir mal, was sich in unserem aktuellen Verzeichnis befindet:

AUSGABE

id_ed25519.pubDie Systemadministratoren haben möglicherweise Ihr Home-Verzeichnis mit einigen hilfreichen Dateien, Ordnern und Verknüpfungen (Shortcuts) zu für Sie reserviertem Speicherplatz auf anderen Dateisystemen konfiguriert. Wenn dies nicht der Fall ist, kann Ihr Home-Verzeichnis leer erscheinen. Um dies zu überprüfen, nehmen Sie versteckte Dateien in Ihre Verzeichnisliste auf:

AUSGABE

. .bashrc id_ed25519.pub

.. .sshIn der ersten Spalte ist . ein Verweis auf das aktuelle

Verzeichnis und .. ein Verweis auf dessen übergeordnetes

Verzeichnis (/home). Sie können die anderen Dateien oder

ähnliche Dateien sehen, müssen es aber nicht: .bashrc ist

eine Shell-Konfigurationsdatei, die Sie mit Ihren Präferenzen bearbeiten

können; und .ssh ist ein Verzeichnis, das SSH-Schlüssel und

eine Aufzeichnung der autorisierten Verbindungen speichert.

Installieren Sie Ihren SSH-Schlüssel

Es gibt vielleicht einen besseren Weg

Die Richtlinien und Praktiken für den Umgang mit SSH-Schlüsseln variieren von HPC-Cluster zu HPC-Cluster: Befolgen Sie die von den Cluster-Administratoren oder der Dokumentation bereitgestellten Hinweise. Insbesondere wenn es ein Online-Portal für die Verwaltung von SSH-Schlüsseln gibt, verwenden Sie dieses anstelle der hier beschriebenen Anweisungen.

Wenn Sie Ihren öffentlichen SSH-Schlüssel mit scp

übertragen haben, sollten Sie id_ed25519.pub in Ihrem

Home-Verzeichnis sehen. Um diesen Schlüssel zu “installieren”, muss er

in einer Datei namens authorized_keys unter dem Ordner

.ssh aufgeführt sein.

Wenn der Ordner .ssh oben nicht aufgeführt wurde, dann

existiert er noch nicht: Erstellen Sie ihn.

Verwenden Sie nun cat, um Ihren öffentlichen Schlüssel

zu drucken, aber leiten Sie die Ausgabe um, indem Sie sie an die Datei

authorized_keys anhängen:

Das war’s! Trennen Sie die Verbindung und versuchen Sie dann, sich wieder bei der Gegenstelle anzumelden: Wenn Ihr Schlüssel und Ihr Agent korrekt konfiguriert wurden, sollten Sie nicht nach dem Passwort für Ihren SSH-Schlüssel gefragt werden.

- Ein HPC-System ist eine Gruppe von vernetzten Maschinen.

- HPC-Systeme bieten typischerweise Login-Knoten und eine Reihe von Worker-Knoten.

- Die Ressourcen auf den unabhängigen (Arbeits-)Knoten können in Umfang und Art variieren (Menge des Arbeitsspeichers, Prozessorarchitektur, Verfügbarkeit von über das Netzwerk eingebundenen Dateisystemen usw.).

- Dateien, die auf einem Knoten gespeichert sind, sind auf allen Knoten verfügbar.

Content from Arbeiten auf einem entfernten HPC-System

Zuletzt aktualisiert am 2026-01-15 | Diese Seite bearbeiten

Übersicht

Fragen

- “Was ist ein HPC-System?”

- “Wie funktioniert ein HPC-System?”

- “Wie melde ich mich bei einem entfernten HPC-System an?”

Ziele

- “Verbinden Sie sich mit einem entfernten HPC-System.”

- “Verstehen Sie die allgemeine HPC-Systemarchitektur.”

Was ist ein HPC-System?

Die Begriffe “Cloud”, “Cluster” und “High-Performance Computing” oder “HPC” werden in verschiedenen Zusammenhängen und mit unterschiedlichen Bedeutungen verwendet. Was bedeuten sie also? Und was noch wichtiger ist: Wie verwenden wir sie bei unserer Arbeit?

Die Cloud ist ein allgemeiner Begriff, der sich auf Computerressourcen bezieht, die a) den Benutzern auf Anfrage oder nach Bedarf zur Verfügung gestellt werden und b) reale oder virtuelle Ressourcen darstellen, die sich überall auf der Erde befinden können. So kann beispielsweise ein großes Unternehmen mit Rechenressourcen in Brasilien, Simbabwe und Japan diese Ressourcen als seine eigene interne Cloud verwalten, und dasselbe Unternehmen kann auch kommerzielle Cloud-Ressourcen von Amazon oder Google nutzen. Cloud-Ressourcen können sich auf Maschinen beziehen, die relativ einfache Aufgaben ausführen, wie z. B. die Bereitstellung von Websites, die Bereitstellung von gemeinsamem Speicherplatz, die Bereitstellung von Webdiensten (z. B. E-Mail oder Social-Media-Plattformen) sowie traditionellere rechenintensive Aufgaben wie die Ausführung einer Simulation.

Der Begriff HPC-System beschreibt dagegen eine eigenständige Ressource für rechenintensive Arbeitslasten. Sie bestehen in der Regel aus einer Vielzahl integrierter Verarbeitungs- und Speicherelemente, die darauf ausgelegt sind, große Datenmengen und/oder eine große Anzahl von Gleitkommaoperationen (FLOPS) mit der höchstmöglichen Leistung zu verarbeiten. So sind zum Beispiel alle Maschinen auf der Top-500 Liste HPC-Systeme. Um diesen Anforderungen gerecht zu werden, muss eine HPC-Ressource an einem bestimmten, festen Standort vorhanden sein: Netzwerkkabel können nur bis zu einem bestimmten Punkt verlegt werden, und elektrische und optische Signale können nur mit einer bestimmten Geschwindigkeit übertragen werden.

Der Begriff “Cluster” wird häufig für kleine bis mittelgroße HPC-Ressourcen verwendet, die weniger beeindruckend sind als die [Top-500] (https://www.top500.org). Cluster werden oft in Rechenzentren unterhalten, die mehrere solcher Systeme unterstützen, die alle ein gemeinsames Netzwerk und einen gemeinsamen Speicher nutzen, um gemeinsame rechenintensive Aufgaben zu unterstützen.

Anmelden

Der erste Schritt bei der Nutzung eines Clusters besteht darin, eine Verbindung zwischen unserem Laptop und dem Cluster herzustellen. Wenn wir an einem Computer sitzen (oder stehen, oder ihn in der Hand oder am Handgelenk halten), erwarten wir eine visuelle Anzeige mit Symbolen, Widgets und vielleicht einigen Fenstern oder Anwendungen: eine grafische Benutzeroberfläche (GUI). Da es sich bei Computerclustern um entfernte Ressourcen handelt, mit denen wir uns über oft langsame oder verzögerte Schnittstellen (insbesondere WiFi und VPNs) verbinden, ist es praktischer, eine Befehlszeilenschnittstelle (CLI) zu verwenden, bei der Befehle und Ergebnisse nur über Text übertragen werden. Alles, was nicht Text ist (z. B. Bilder), muss auf die Festplatte geschrieben und mit einem separaten Programm geöffnet werden.

Wenn Sie jemals die Windows-Eingabeaufforderung oder das macOS-Terminal geöffnet haben, haben Sie ein CLI gesehen. Wenn Sie bereits an den The Carpentries-Kursen über die UNIX-Shell oder Versionskontrolle teilgenommen haben, haben Sie die CLI auf Ihrem lokalen Rechner ziemlich ausgiebig genutzt. Der einzige Schritt, der hier gemacht werden muss, ist das Öffnen einer CLI auf einem entfernten Rechner, wobei einige Vorsichtsmaßnahmen getroffen werden müssen, damit andere Leute im Netzwerk die Befehle, die Sie ausführen, oder die Ergebnisse, die der entfernte Rechner zurücksendet, nicht sehen (oder ändern) können. Wir werden das Secure SHell-Protokoll (oder SSH) verwenden, um eine verschlüsselte Netzwerkverbindung zwischen zwei Rechnern herzustellen, die es Ihnen ermöglicht, Text und Daten zu senden und zu empfangen, ohne sich um neugierige Blicke sorgen zu müssen.

Stellen Sie sicher, dass Sie einen SSH-Client auf Ihrem Laptop

installiert haben. Lesen Sie den Abschnitt setup für weitere Details. SSH-Clients sind in der

Regel Befehlszeilen-Tools, bei denen Sie als einziges Argument die

Adresse des entfernten Rechners angeben müssen. Wenn sich Ihr

Benutzername auf dem entfernten System von dem unterscheidet, den Sie

lokal verwenden, müssen Sie auch diesen angeben. Wenn Ihr SSH-Client

über eine grafische Oberfläche verfügt, wie z. B. PuTTY oder MobaXterm,

geben Sie diese Argumente an, bevor Sie auf “Verbinden” klicken Im

Terminal schreiben Sie etwa ssh userName@hostname, wobei

das “@”-Symbol verwendet wird, um die beiden Teile eines einzelnen

Arguments zu trennen.

Öffnen Sie Ihr Terminal oder Ihren grafischen SSH-Client und melden Sie sich mit Ihrem Benutzernamen und dem entfernten Computer, den Sie von der Außenwelt aus erreichen können, cluster.hpc-carpentry.org, am Cluster an.

Denken Sie daran, yourUsername durch Ihren Benutzernamen

oder den von den Dozenten angegebenen zu ersetzen. Möglicherweise werden

Sie nach Ihrem Passwort gefragt. Achtung: Die Zeichen, die Sie nach der

Passwortabfrage eingeben, werden nicht auf dem Bildschirm angezeigt. Die

normale Ausgabe wird fortgesetzt, sobald Sie Enter

drücken.

Wo sind wir?

Sehr oft sind viele Benutzer versucht, sich eine

Hochleistungsrechner-Installation als eine riesige, magische Maschine

vorzustellen. Manchmal gehen sie davon aus, dass der Computer, an dem

sie sich angemeldet haben, der gesamte Computer-Cluster ist. Was

passiert also wirklich? Bei welchem Computer haben wir uns angemeldet?

Der Name des aktuellen Computers, auf dem wir angemeldet sind, kann mit

dem Befehl hostname überprüft werden. (Vielleicht bemerken

Sie auch, dass der aktuelle Hostname auch Teil unserer

Eingabeaufforderung ist)

AUSGABE

login1Was befindet sich in Ihrem Home-Verzeichnis?

Die Systemadministratoren haben Ihr Home-Verzeichnis möglicherweise

mit einigen hilfreichen Dateien, Ordnern und Verknüpfungen (Shortcuts)

zu für Sie reserviertem Speicherplatz auf anderen Dateisystemen

konfiguriert. Schauen Sie sich um und sehen Sie, was Sie finden können.

Tipp: Die Shell-Befehle pwd und ls

können dabei hilfreich sein. Der Inhalt des Home-Verzeichnisses variiert

von Benutzer zu Benutzer. Bitte besprechen Sie alle Unterschiede, die

Sie feststellen, mit Ihren Nachbarn.

Die tiefste Ebene sollte sich unterscheiden:

yourUsername ist eindeutig. Gibt es Unterschiede im Pfad

auf höheren Ebenen?

Wenn Sie beide leere Verzeichnisse haben, werden sie identisch aussehen. Wenn Sie oder Ihr Nachbar das System vorher benutzt haben, kann es Unterschiede geben. Woran arbeiten Sie?

Verwenden Sie pwd (print working directory), um den

aktuellen Verzeichnispfad zu drucken:

Sie können ls (list) ausführen, um den Inhalt des

Verzeichnisses aufzulisten, obwohl es möglich ist, dass nichts angezeigt

wird (wenn keine Dateien bereitgestellt wurden). Um sicher zu gehen,

benutzen Sie das -a Flag, um auch versteckte Dateien

anzuzeigen.

Dies zeigt zumindest das aktuelle Verzeichnis als . und

das übergeordnete Verzeichnis als .. an.

Knoten

Die einzelnen Computer, aus denen ein Cluster besteht, werden in der Regel Knoten genannt (obwohl man sie auch Server, Rechner und Maschinen nennen kann). In einem Cluster gibt es verschiedene Arten von Knoten für verschiedene Arten von Aufgaben. Der Knoten, an dem Sie sich gerade befinden, wird Kopfknoten, Anmeldeknoten, Landeplatz oder Übermittlungsknoten genannt. Ein Anmeldeknoten dient als Zugangspunkt zum Cluster.

Als Gateway ist er gut geeignet, um Dateien hoch- und herunterzuladen, Software einzurichten und schnelle Tests durchzuführen. Im Allgemeinen sollte der Login-Knoten nicht für zeit- oder ressourcenintensive Aufgaben verwendet werden. Sie sollten darauf achten und sich bei den Betreibern Ihrer Website oder in der Dokumentation darüber informieren, was erlaubt ist und was nicht. In diesen Lektionen werden wir es vermeiden, Aufträge auf dem Hauptknoten auszuführen.

Dedizierte Transferknoten

Wenn Sie größere Datenmengen in oder aus dem Cluster übertragen wollen, bieten einige Systeme dedizierte Knoten nur für Datentransfers an. Die Motivation dafür liegt darin, dass größere Datentransfers den Betrieb des Login-Knotens für alle anderen nicht behindern sollen. Erkundigen Sie sich in der Dokumentation Ihres Clusters oder bei dessen Support-Team, ob ein solcher Transferknoten verfügbar ist. Als Faustregel gilt, dass alle Übertragungen eines Volumens größer als 500 MB bis 1 GB als groß zu betrachten sind. Diese Zahlen können sich jedoch ändern, z.B. abhängig von der Netzwerkverbindung von Ihnen und Ihrem Cluster oder anderen Faktoren.

Die eigentliche Arbeit in einem Cluster wird von den Arbeiterknoten (oder Rechenknoten) erledigt. Arbeiterknoten gibt es in vielen Formen und Größen, aber im Allgemeinen sind sie für lange oder schwierige Aufgaben bestimmt, die viele Rechenressourcen erfordern.

Die gesamte Interaktion mit den Arbeiterknoten wird von einer speziellen Software namens Scheduler abgewickelt (der Scheduler, der in dieser Lektion verwendet wird, heißt Slurm). Wir werden in der nächsten Lektion mehr darüber lernen, wie man den Scheduler benutzt, um Jobs zu übermitteln, aber für den Moment kann er uns auch mehr Informationen über die Arbeiterknoten liefern.

Zum Beispiel können wir alle Arbeiterknoten anzeigen, indem wir den

Befehl sinfo ausführen.

AUSGABE

PARTITION AVAIL TIMELIMIT NODES STATE NODELIST

cpubase_bycore_b1* up infinite 4 idle node[1-2],smnode[1-2]

node up infinite 2 idle node[1-2]

smnode up infinite 2 idle smnode[1-2]Es gibt auch spezialisierte Maschinen, die für die Verwaltung von Plattenspeicher, Benutzerauthentifizierung und andere infrastrukturbezogene Aufgaben verwendet werden. Obwohl wir uns normalerweise nicht direkt an diesen Maschinen anmelden oder mit ihnen interagieren, ermöglichen sie eine Reihe von Schlüsselfunktionen, wie z.B. die Sicherstellung, dass unser Benutzerkonto und unsere Dateien im gesamten HPC-System verfügbar sind.

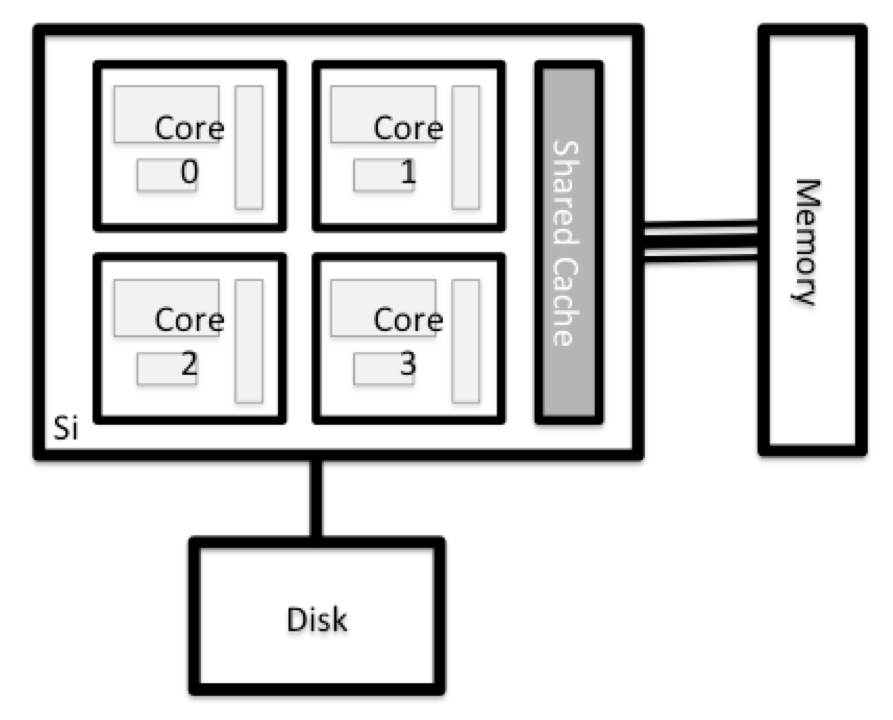

Was befindet sich in einem Knoten?

Alle Knoten in einem HPC-System haben die gleichen Komponenten wie Ihr eigener Laptop oder Desktop: CPUs (manchmal auch Prozessoren oder Cores genannt), Speicher (oder RAM) und Festplattenspeicher. CPUs sind das Werkzeug eines Computers, um Programme und Berechnungen auszuführen. Informationen über eine aktuelle Aufgabe werden im Arbeitsspeicher des Computers gespeichert. Der Begriff “Festplatte” bezieht sich auf den gesamten Speicher, auf den wie auf ein Dateisystem zugegriffen werden kann. In der Regel handelt es sich dabei um Speicher, der Daten dauerhaft speichern kann, d. h. die Daten sind auch dann noch vorhanden, wenn der Computer neu gestartet wurde. Während dieser Speicher lokal sein kann (eine Festplatte ist darin installiert), ist es üblicher, dass Knoten mit einem gemeinsam genutzten, entfernten Dateiserver oder einem Cluster von Servern verbunden sind.

Untersuche deinen Computer

Versuchen Sie herauszufinden, wie viele CPUs und wie viel

Arbeitsspeicher auf Ihrem persönlichen Computer verfügbar sind. Beachten

Sie, dass Sie sich zuerst abmelden müssen, wenn Sie bei dem entfernten

Computer-Cluster angemeldet sind. Geben Sie dazu Ctrl+d

oder exit ein:

Es gibt mehrere Möglichkeiten, dies zu tun. Die meisten Betriebssysteme haben einen grafischen Systemmonitor, wie den Windows Task Manager. Ausführlichere Informationen können manchmal über die Befehlszeile abgerufen werden. Einige der Befehle, die auf einem Linux-System verwendet werden, sind zum Beispiel:

Systemdienstprogramme ausführen

Lesen von /proc

Verwenden Sie einen Systemmonitor

Erkundung des Anmeldeknotens

Vergleichen Sie nun die Ressourcen Ihres Computers mit denen des Hauptknotens.

BASH

[you@laptop:~]$ ssh yourUsername@cluster.hpc-carpentry.org

[yourUsername@login1 ~] nproc --all

[yourUsername@login1 ~] free -mSie können mehr Informationen über die Prozessoren erhalten, indem

Sie lscpu benutzen, und eine Menge Details über den

Speicher, indem Sie die Datei /proc/meminfo lesen:

Sie können auch die verfügbaren Dateisysteme mit df

(disk freespace )untersuchen, um Festplattenspeicher anzuzeigen. Das

Flag -h zeigt die Größen in einem menschenfreundlichen

Format an, d.h. GB statt B. Das type Flag -T zeigt, welche

Art von Dateisystem jede Ressource ist.

Die lokalen Dateisysteme (ext, tmp, xfs, zfs) hängen davon ab, ob Sie sich auf demselben Anmeldeknoten (oder Rechenknoten, später) befinden. Netzwerk-Dateisysteme (beegfs, cifs, gpfs, nfs, pvfs) werden ähnlich sein — können aber yourUsername enthalten, abhängig davon, wie es [gemountet] wird (https://en.wikipedia.org/wiki/Mount_(computing)).

Gemeinsame Dateisysteme

Dies ist ein wichtiger Punkt: Dateien, die auf einem Knoten (Computer) gespeichert sind, sind oft überall im Cluster verfügbar!

Vergleichen Sie Ihren Computer, den Anmeldeknoten und den Berechnungsknoten

Vergleichen Sie die Anzahl der Prozessoren und des Arbeitsspeichers Ihres Laptops mit den Zahlen, die Sie auf dem Hauptknoten und dem Arbeitsknoten des Clusters sehen. Diskutieren Sie die Unterschiede mit Ihrem Nachbarn.

Was denken Sie, welche Auswirkungen die Unterschiede auf die Durchführung Ihrer Forschungsarbeit auf den verschiedenen Systemen und Knotenpunkten haben könnten?

Unterschiede zwischen den Knoten

Viele HPC-Cluster haben eine Vielzahl von Knoten, die für bestimmte Arbeitslasten optimiert sind. Einige Knoten verfügen über eine größere Speichermenge oder spezialisierte Ressourcen wie grafische Verarbeitungseinheiten (GPUs).

Mit all dem im Hinterkopf werden wir nun besprechen, wie man mit dem Scheduler des Clusters kommuniziert und ihn benutzt, um unsere Skripte und Programme laufen zu lassen!

- “Ein HPC-System ist eine Gruppe von vernetzten Maschinen.”

- “HPC-Systeme bieten normalerweise Anmeldeknoten und eine Reihe von Arbeitsknoten.”

- “Die Ressourcen, die sich auf unabhängigen (Arbeits-)Knoten befinden, können in Umfang und Art variieren (Menge des Arbeitsspeichers, Prozessorarchitektur, Verfügbarkeit von im Netzwerk eingebundenen Dateisystemen usw.).”

- “Dateien, die auf einem Knoten gespeichert sind, sind auf allen Knoten verfügbar.”

Content from Grundlagen des Schedulers

Zuletzt aktualisiert am 2026-01-15 | Diese Seite bearbeiten

Übersicht

Fragen

- Was ist ein Scheduler und warum braucht ein Cluster einen?

- Wie starte ich ein Programm zur Ausführung auf einem Rechenknoten im Cluster?

- Wie kann ich die Ausgabe eines Programms erfassen, das auf einem Knoten im Cluster ausgeführt wird?

Ziele

- Übermittelt ein einfaches Skript an den Cluster.

- Überwachen Sie die Ausführung von Aufträgen mit Hilfe von Kommandozeilenwerkzeugen.

- Überprüfen Sie die Ausgabe- und Fehlerdateien Ihrer Aufträge.

- Finden Sie den richtigen Ort, um große Datensätze auf dem Cluster abzulegen.

Job Scheduler

Ein HPC-System kann Tausende von Knoten und Tausende von Benutzern haben. Wie wird entschieden, wer was und wann bekommt? Wie wird sichergestellt, dass eine Aufgabe mit den erforderlichen Ressourcen ausgeführt wird? Diese Aufgabe wird von einer speziellen Software, dem Scheduler, übernommen. Auf einem HPC-System verwaltet der Scheduler, welche Aufgaben wo und wann ausgeführt werden.

Die folgende Abbildung vergleicht diese Aufgaben eines Job Schedulers mit denen eines Kellners in einem Restaurant. Wenn Sie sich vorstellen können, dass Sie eine Weile in einer Schlange warten mussten, um in ein beliebtes Restaurant zu kommen, dann verstehen Sie jetzt vielleicht, warum Ihr Job manchmal nicht sofort startet, wie bei Ihrem Laptop.

Der in dieser Lektion verwendete Scheduler ist Slurm. Obwohl Slurm nicht überall verwendet wird, ist die Ausführung von Aufträgen ziemlich ähnlich, unabhängig davon, welche Software verwendet wird. Die genaue Syntax kann sich ändern, aber die Konzepte bleiben die gleichen.

Ausführen eines Batch-Jobs

Die einfachste Anwendung des Schedulers ist die nicht-interaktive Ausführung eines Befehls. Jeder Befehl (oder eine Reihe von Befehlen), den Sie auf dem Cluster ausführen möchten, wird als Job bezeichnet, und der Prozess der Verwendung eines Schedulers zur Ausführung des Jobs wird Batch Job Submission genannt.

In diesem Fall handelt es sich bei dem Auftrag, den wir ausführen wollen, um ein Shell-Skript - im Wesentlichen eine Textdatei mit einer Liste von UNIX-Befehlen, die nacheinander ausgeführt werden sollen. Unser Shell-Skript wird aus drei Teilen bestehen:

- In der allerersten Zeile fügen Sie

#!/bin/bashein. Das#!(ausgesprochen “hash-bang” oder “shebang”) sagt dem Computer, welches Programm den Inhalt dieser Datei verarbeiten soll. In diesem Fall teilen wir ihm mit, dass die folgenden Befehle für die Kommandozeilen-Shell geschrieben sind (in der wir bisher alles gemacht haben). - Irgendwo unterhalb der ersten Zeile fügen wir einen

echo-Befehl mit einer freundlichen Begrüßung ein. Wenn es ausgeführt wird, gibt das Shell-Skript im Terminal alles aus, was nachechokommt.-

echo -ndruckt alles, was folgt, ohne die Zeile mit einem Zeilenumbruch zu beenden.

-

- In der letzten Zeile rufen wir den Befehl

hostnameauf, der den Namen des Rechners ausgibt, auf dem das Skript ausgeführt wird.

Erstellen unseres Testjobs

Führen Sie das Skript aus. Wird es auf dem Cluster oder nur auf unserem Anmeldeknoten ausgeführt?

Dieses Skript lief auf dem Anmeldeknoten, aber wir wollen die

Vorteile der Rechenknoten nutzen: Wir brauchen den Scheduler, um

example-job.sh in die Warteschlange zu stellen, damit er

auf einem Rechenknoten läuft.

Um diese Aufgabe an den Scheduler zu senden, benutzen wir den Befehl

sbatch. Dies erzeugt einen Job, der das

Skript ausführt, wenn er an einen Rechenknoten

gesendet wird, den das Warteschlangensystem als verfügbar für

die Ausführung der Arbeit identifiziert hat.

AUSGABE

Submitted batch job 7Und das ist alles, was wir tun müssen, um einen Auftrag abzuschicken.

Unsere Arbeit ist getan - jetzt übernimmt der Scheduler und versucht,

den Auftrag für uns auszuführen. Während der Auftrag darauf wartet,

ausgeführt zu werden, wird er in eine Liste von Aufträgen aufgenommen,

die Warteschlange. Um den Status unseres Jobs (oder Auftrags)

zu überprüfen, können wir die Warteschlange mit dem Befehl

squeue -u yourUsername überprüfen.

AUSGABE

JOBID PARTITION NAME USER ST TIME NODES NODELIST(REASON)

9 cpubase_b example- user01 R 0:05 1 node1Wir können alle Details zu unserem Auftrag sehen, vor allem, dass er

sich im Status R oder RUNNING befindet.

Manchmal müssen unsere Aufträge in einer Warteschlange warten

(PENDING) oder haben einen Fehler (E).

Wo ist die Ausgabe?

Auf dem Login-Knoten gab dieses Skript eine Ausgabe auf dem Terminal

aus – aber jetzt, wenn squeue anzeigt, dass der Job beendet

ist, wurde nichts auf dem Terminal ausgegeben.

Die Ausgabe eines Cluster-Jobs wird normalerweise in eine Datei in

dem Verzeichnis umgeleitet, aus dem Sie ihn gestartet haben. Verwenden

Sie ls zum Suchen und cat zum Lesen der

Datei.

Anpassen eines Jobs

Der Auftrag, den wir gerade ausgeführt haben, verwendete alle Standardoptionen des Schedulers. In einem realen Szenario ist das wahrscheinlich nicht das, was wir wollen. Die Standardoptionen stellen ein vernünftiges Minimum dar. Wahrscheinlich benötigen wir mehr Kerne, mehr Arbeitsspeicher, mehr Zeit und andere spezielle Überlegungen. Um Zugang zu diesen Ressourcen zu erhalten, müssen wir unser Jobskript anpassen.

Kommentare in UNIX-Shell-Skripten (gekennzeichnet durch

#) werden normalerweise ignoriert, aber es gibt Ausnahmen.

Zum Beispiel gibt der spezielle Kommentar #! am Anfang von

Skripten an, welches Programm benutzt werden soll, um es auszuführen

(typischerweise steht hier #!/usr/bin/env bash). Scheduler

wie Slurm haben auch einen speziellen Kommentar, um spezielle

Scheduler-spezifische Optionen zu kennzeichnen. Obwohl diese Kommentare

von Scheduler zu Scheduler unterschiedlich sind, ist der spezielle

Kommentar von Slurm #SBATCH. Alles, was dem Kommentar

#SBATCH folgt, wird als Anweisung an den Scheduler

interpretiert.

Lassen Sie uns dies an einem Beispiel verdeutlichen. Standardmäßig

ist der Name eines Jobs der Name des Skripts, aber mit der Option

-J kann man den Namen eines Jobs ändern. Fügen Sie eine

Option in das Skript ein:

Übermitteln Sie den Auftrag und überwachen Sie seinen Status:

AUSGABE

JOBID PARTITION NAME USER ST TIME NODES NODELIST(REASON)

10 cpubase_b hello-wo user01 R 0:02 1 node1Fantastisch, wir haben den Namen unseres Jobs erfolgreich geändert!

Ressourcenanfragen

Was ist mit wichtigeren Änderungen, wie der Anzahl der Kerne und des Speichers für unsere Jobs? Eine Sache, die bei der Arbeit an einem HPC-System absolut entscheidend ist, ist die Angabe der für die Ausführung eines Auftrags erforderlichen Ressourcen. So kann der Scheduler die richtige Zeit und den richtigen Ort für die Ausführung unseres Auftrags finden. Wenn Sie die Anforderungen (z. B. die benötigte Zeit) nicht angeben, werden Sie wahrscheinlich mit den Standardressourcen Ihrer Website arbeiten, was wahrscheinlich nicht das ist, was Sie wollen.

Es folgen mehrere wichtige Ressourcenanfragen:

--ntasks=<ntasks>oder-n <ntasks>: Wie viele CPU-Kerne benötigt Ihr Job insgesamt?--time <days-hours:minutes:seconds>oder-t <days-hours:minutes:seconds>: Wie viel reale Zeit (Walltime) wird Ihr Job für die Ausführung benötigen? Der Teil<days>kann weggelassen werden.--mem=<megabytes>: Wie viel Speicher auf einem Knoten benötigt Ihr Auftrag in Megabyte? Sie können auch Gigabytes angeben, indem Sie ein kleines “g” anhängen (Beispiel:--mem=5g)--nodes=<nnodes>oder-N <nnodes>: Auf wie vielen separaten Rechnern muss Ihr Auftrag laufen? Beachten Sie, dass, wenn Sientasksauf eine Zahl setzen, die größer ist als die, die eine Maschine bieten kann, Slurm diesen Wert automatisch einstellt.

Beachten Sie, dass das bloße Anfordern dieser Ressourcen Ihren Auftrag nicht schneller laufen lässt und auch nicht unbedingt bedeutet, dass Sie alle diese Ressourcen verbrauchen werden. Es bedeutet nur, dass sie Ihnen zur Verfügung gestellt werden. Es kann sein, dass Ihr Auftrag am Ende weniger Speicher, weniger Zeit oder weniger Knoten benötigt, als Sie angefordert haben, und er wird trotzdem ausgeführt.

Es ist am besten, wenn Ihre Anfragen die Anforderungen Ihres Auftrags genau widerspiegeln. In einer späteren Folge dieser Lektion werden wir mehr darüber sprechen, wie Sie sicherstellen können, dass Sie die Ressourcen effektiv nutzen.

Übermittlung von Ressourcenanfragen

Ändern Sie unser hostname-Skript so, dass es eine Minute

lang läuft, und senden Sie dann einen Job dafür an den Cluster.

Ressourcenanforderungen sind normalerweise verbindlich. Wenn Sie diese überschreiten, wird Ihr Auftrag abgebrochen. Nehmen wir die Walltime als Beispiel. Wir fordern 1 Minute Walltime an und versuchen, einen Auftrag zwei Minuten lang laufen zu lassen.

BASH

#!/bin/bash

#SBATCH -J long_job

#SBATCH -t 00:01 # timeout in HH:MM

echo "This script is running on ... "

sleep 240 # time in seconds

hostnameSenden Sie den Auftrag ab und warten Sie, bis er beendet ist. Sobald er beendet ist, überprüfen Sie die Protokolldatei.

AUSGABE

This script is running on ...

slurmstepd: error: *** JOB 12 ON node1 CANCELLED AT 2021-02-19T13:55:57

DUE TO TIME LIMIT ***Unser Auftrag wurde abgebrochen, weil er die angeforderte Menge an Ressourcen überschritten hat. Obwohl dies hart erscheint, handelt es sich dabei um eine Funktion. Die strikte Einhaltung der Ressourcenanforderungen ermöglicht es dem Scheduler, den bestmöglichen Platz für Ihre Jobs zu finden. Noch wichtiger ist jedoch, dass dadurch sichergestellt wird, dass ein anderer Benutzer nicht mehr Ressourcen verwenden kann, als ihm zugewiesen wurden. Wenn ein anderer Benutzer einen Fehler macht und versehentlich versucht, alle Kerne oder den gesamten Speicher eines Knotens zu nutzen, wird Slurm entweder seinen Job auf die angeforderten Ressourcen beschränken oder den Job ganz beenden. Andere Jobs auf dem Knoten sind davon nicht betroffen. Das bedeutet, dass ein Benutzer nicht die Erfahrungen anderer Benutzer durcheinander bringen kann, die einzigen Jobs, die von einem Fehler in der Planung betroffen sind, sind die eigenen.

Abbrechen eines Jobs

Manchmal machen wir einen Fehler und müssen einen Auftrag abbrechen.

Das kann man mit dem Befehl scancel machen. Lassen Sie uns

einen Job abschicken und ihn dann mit seiner Jobnummer abbrechen (denken

Sie daran, die Walltime so zu ändern, dass er lange genug läuft, damit

Sie ihn abbrechen können, bevor er beendet wird).

AUSGABE

Submitted batch job 13

JOBID PARTITION NAME USER ST TIME NODES NODELIST(REASON)

13 cpubase_b long_job user01 R 0:02 1 node1Stornieren Sie nun den Auftrag mit seiner Auftragsnummer (die in Ihrem Terminal ausgedruckt wird). Eine saubere Rückkehr Ihrer Eingabeaufforderung zeigt an, dass die Anfrage zum Abbrechen des Auftrags erfolgreich war.

BASH

[yourUsername@login1 ~] scancel 38759

# It might take a minute for the job to disappear from the queue...

[yourUsername@login1 ~] squeue -u yourUsernameAUSGABE

JOBID PARTITION NAME USER ST TIME NODES NODELIST(REASON)Abbrechen mehrerer Jobs

Wir können auch alle unsere Aufträge auf einmal mit der Option

-u löschen. Damit werden alle Aufträge für einen bestimmten

Benutzer (in diesem Fall für Sie selbst) gelöscht. Beachten Sie, dass

Sie nur Ihre eigenen Aufträge löschen können.

Versuchen Sie, mehrere Aufträge einzureichen und sie dann alle abzubrechen.

Andere Arten von Jobs

Bis zu diesem Punkt haben wir uns auf die Ausführung von Jobs im

Batch-Modus konzentriert. Slurm bietet auch die

Möglichkeit, eine interaktive Sitzung zu starten.

Es gibt sehr häufig Aufgaben, die interaktiv erledigt werden müssen.

Ein ganzes Job-Skript zu erstellen, wäre vielleicht übertrieben, aber

die Menge der benötigten Ressourcen ist zu groß für einen Login-Knoten.

Ein gutes Beispiel hierfür ist die Erstellung eines Genomindexes für das

Alignment mit einem Tool wie HISAT2.

Glücklicherweise können wir diese Art von Aufgaben einmalig mit

srun ausführen.

srun führt einen einzelnen Befehl auf dem Cluster aus

und beendet sich dann. Lassen Sie uns dies demonstrieren, indem wir den

Befehl hostname mit srun ausführen. (Wir

können einen srun-Job mit Ctrl-c

abbrechen.)

AUSGABE

smnode1srun akzeptiert die gleichen Optionen wie

sbatch. Allerdings werden diese Optionen nicht in einem

Skript angegeben, sondern auf der Kommandozeile, wenn ein Job gestartet

wird. Um einen Job zu starten, der 2 CPUs benutzt, könnte man z.B. den

folgenden Befehl verwenden:

AUSGABE

This job will use 2 CPUs.

This job will use 2 CPUs.Typischerweise wird die resultierende Shell-Umgebung die gleiche sein

wie die für sbatch.

Interaktive Jobs

Manchmal braucht man viele Ressourcen für die interaktive Nutzung.

Vielleicht führen wir zum ersten Mal eine Analyse durch oder versuchen,

einen Fehler zu beheben, der bei einem früheren Auftrag aufgetreten ist.

Glücklicherweise macht es Slurm einfach, einen interaktiven Job mit

srun zu starten:

Sie sollten nun eine Bash-Eingabeaufforderung erhalten. Beachten Sie,

dass sich die Eingabeaufforderung wahrscheinlich ändert, um Ihren neuen

Standort wiederzugeben, in diesem Fall den Rechenknoten, an dem wir

angemeldet sind. Sie können dies auch mit hostname

überprüfen.

Erstellen von Remote-Grafiken

Um die grafische Ausgabe innerhalb Ihrer Aufträge zu sehen, müssen

Sie die X11-Weiterleitung verwenden. Um diese Funktion zu aktivieren,

verwenden Sie die Option -Y, wenn Sie sich mit dem Befehl

ssh anmelden, z.B.

ssh -Y yourUsername@cluster.hpc-carpentry.org.

Um zu demonstrieren, was passiert, wenn Sie ein Grafikfenster auf dem

entfernten Knoten erstellen, verwenden Sie den Befehl

xeyes. Ein relativ hübsches Augenpaar sollte auftauchen

(drücken Sie Ctrl-C, um zu stoppen). Wenn Sie einen Mac

verwenden, müssen Sie XQuartz installiert (und Ihren Computer neu

gestartet) haben, damit dies funktioniert.

Wenn Ihr Cluster das slurm-spank-x11

Plugin installiert hat, können Sie die X11-Weiterleitung innerhalb

interaktiver Jobs sicherstellen, indem Sie die Option --x11

für srun mit dem Befehl srun --x11 --pty bash

verwenden.

Wenn Sie mit dem interaktiven Job fertig sind, geben Sie

exit ein, um Ihre Sitzung zu beenden.

- Der Scheduler verwaltet die Aufteilung der Rechenressourcen zwischen den Benutzern.

- Ein Job ist einfach ein Shell-Skript.

- Fordern Sie geringfügig mehr Ressourcen an, als Sie brauchen werden.

Content from Umgebungsvariablen

Zuletzt aktualisiert am 2026-01-15 | Diese Seite bearbeiten

Übersicht

Fragen

- Wie werden Variablen in der Unix-Shell gesetzt und angesprochen?

- Wie kann ich Variablen verwenden, um den Ablauf eines Programms zu verändern?

Ziele

- Verstehen, wie Variablen in der Shell implementiert werden

- Den Wert einer bestehenden Variable auslesen

- Erstellen Sie neue Variablen und ändern Sie deren Werte

- Ändern Sie das Verhalten eines Programms mit Hilfe einer Umgebungsvariablen

- Erkläre, wie die Shell die Variable

PATHbenutzt, um nach ausführbaren Dateien zu suchen

Herkunft der Episode

Diese Folge wurde aus der [Shell-Extras-Folge über Shell-Variablen] (https://github.com/carpentries-incubator/shell-extras/blob/gh-pages/_episodes/08-environment-variables.md) und der [HPC-Shell-Folge über Skripte] (https://github.com/hpc-carpentry/hpc-shell/blob/gh-pages/_episodes/05-scripts.md) neu zusammengestellt.

Die Shell ist nur ein Programm, und wie andere Programme auch, hat sie Variablen. Diese Variablen steuern ihre Ausführung, so dass Sie durch Ändern ihrer Werte das Verhalten der Shell (und mit etwas mehr Aufwand auch das Verhalten anderer Programme) beeinflussen können.

Variablen sind eine gute Möglichkeit, Informationen unter einem Namen zu speichern, auf den man später zugreifen kann. In Programmiersprachen wie Python und R können Variablen so ziemlich alles speichern, was man sich vorstellen kann. In der Shell speichern sie normalerweise nur Text. Der beste Weg, um zu verstehen, wie sie funktionieren, ist, sie in Aktion zu sehen.

Beginnen wir damit, den Befehl set auszuführen und

einige der Variablen in einer typischen Shell-Sitzung zu betrachten:

AUSGABE

COMPUTERNAME=TURING

HOME=/home/vlad

HOSTNAME=TURING

HOSTTYPE=i686

NUMBER_OF_PROCESSORS=4

PATH=/Users/vlad/bin:/usr/local/git/bin:/usr/bin:/bin:/usr/sbin:/sbin:/usr/local/bin

PWD=/home/vlad

UID=1000

USERNAME=vlad

...Wie Sie sehen können, gibt es ziemlich viele - tatsächlich vier- oder

fünfmal so viele, wie hier gezeigt werden. Und ja, set zu

benutzen, um Dinge anzuzeigen, mag ein wenig seltsam

erscheinen, selbst für Unix, aber wenn Sie ihr keine Argumente geben,

kann sie Ihnen auch Dinge zeigen, die Sie einstellen

könnten.

Jede Variable hat einen Namen. Alle Werte von Shell-Variablen sind

Zeichenketten, auch solche (wie UID), die wie Zahlen

aussehen. Es liegt an den Programmen, diese Zeichenketten bei Bedarf in

andere Typen zu konvertieren. Wenn ein Programm zum Beispiel

herausfinden wollte, wie viele Prozessoren der Computer hat, würde es

den Wert der Variablen NUMBER_OF_PROCESSORS von einer

Zeichenkette in eine ganze Zahl umwandeln.

Den Wert einer Variablen anzeigen

Zeigen wir den Wert der Variable HOME:

AUSGABE

HOMEDas gibt nur “HOME” aus, was nicht das ist, was wir wollten (obwohl es das ist, wonach wir eigentlich gefragt haben). Versuchen wir stattdessen dies:

AUSGABE

/home/vladDas Dollarzeichen sagt der Shell, dass wir den Wert der

Variable wollen und nicht ihren Namen. Das funktioniert genau wie bei

Wildcards: die Shell ersetzt die Variable vor der Ausführung

des gewünschten Programms. Dank dieser Erweiterung ist das, was wir

tatsächlich ausführen, echo /home/vlad, was das Richtige

anzeigt.

Erstellen und Ändern von Variablen

Eine Variable zu erstellen ist einfach - wir weisen einem Namen mit

“=” einen Wert zu (wir müssen nur daran denken, dass die Syntax

verlangt, dass keine Leerzeichen um das = herum

sind!)

AUSGABE

DraculaUm den Wert zu ändern, weisen Sie einfach einen neuen Wert zu:

AUSGABE

CamillaUmgebungsvariablen

Als wir den set-Befehl ausführten, sahen wir, dass es

eine Menge Variablen gab, deren Namen in Großbuchstaben geschrieben

waren. Das liegt daran, dass Variablen, die auch von anderen

Programmen verwendet werden können, in Großbuchstaben benannt werden.

Solche Variablen werden Umgebungsvariablen genannt, da es sich

um Shell-Variablen handelt, die für die aktuelle Shell definiert sind

und an alle untergeordneten Shells oder Prozesse vererbt werden.

Um eine Umgebungsvariable zu erstellen, müssen Sie eine

Shell-Variable export angeben. Um zum Beispiel unser

SECRET_IDENTITY für andere Programme, die wir von unserer

Shell aus aufrufen, verfügbar zu machen, können wir folgendes tun:

Sie können die Variable auch in einem einzigen Schritt erstellen und exportieren:

Verwendung von Umgebungsvariablen zur Änderung des Programmverhaltens

Setze eine Shell-Variable TIME_STYLE auf den Wert

iso und prüfe diesen Wert mit dem Befehl

echo.

Führen Sie nun den Befehl ls mit der Option

-l aus (was ein langes Format ergibt).

export die Variable und führen Sie den Befehl

ls -l erneut aus. Bemerkst du einen Unterschied?

Die Variable TIME_STYLE wird von ls nicht

gesehen, bis sie exportiert wird. Zu diesem Zeitpunkt wird sie

von ls benutzt, um zu entscheiden, welches Datumsformat bei

der Darstellung des Zeitstempels von Dateien zu verwenden ist.

Sie können den kompletten Satz von Umgebungsvariablen in Ihrer

aktuellen Shell-Sitzung mit dem Befehl env sehen (der eine

Teilmenge dessen zurückgibt, was der Befehl set uns gegeben

hat). Der komplette Satz von Umgebungsvariablen wird als

Laufzeitumgebung bezeichnet und kann das Verhalten der von

Ihnen ausgeführten Programme beeinflussen.

Job-Umgebungsvariablen

Wenn Slurm einen Job ausführt, setzt es eine Reihe von

Umgebungsvariablen für den Job. Mit einer dieser Variablen können wir

überprüfen, von welchem Verzeichnis aus unser Job-Skript eingereicht

wurde. Die Variable SLURM_SUBMIT_DIR wird auf das

Verzeichnis gesetzt, von dem aus unser Job eingereicht wurde. Ändern Sie

Ihren Job mit Hilfe der Variable SLURM_SUBMIT_DIR so, dass

er das Verzeichnis ausgibt, von dem aus der Job übermittelt wurde.

Um eine Variable oder Umgebungsvariable zu entfernen, können Sie zum

Beispiel den Befehl unset verwenden:

Die PATH Umgebungsvariable

In ähnlicher Weise speichern einige Umgebungsvariablen (wie

PATH) Listen von Werten. In diesem Fall ist die Konvention,

einen Doppelpunkt ‘:’ als Trennzeichen zu verwenden. Wenn ein Programm

die einzelnen Elemente einer solchen Liste benötigt, muss es den

String-Wert der Variablen in Stücke aufteilen.

Schauen wir uns die Variable PATH genauer an. Ihr Wert

definiert den Suchpfad der Shell für ausführbare Programme, d.h. die

Liste der Verzeichnisse, in denen die Shell nach ausführbaren Programmen

sucht, wenn Sie einen Programmnamen eintippen, ohne anzugeben, in

welchem Verzeichnis er sich befindet.

Wenn wir zum Beispiel einen Befehl wie analyze eingeben,

muss die Shell entscheiden, ob sie ./analyze oder

/bin/analyze ausführen soll. Die Regel, die sie dabei

anwendet, ist einfach: Die Shell prüft jedes Verzeichnis in der

Variablen PATH der Reihe nach und sucht nach einem Programm

mit dem gewünschten Namen in diesem Verzeichnis. Sobald sie eine

Übereinstimmung findet, hört sie auf zu suchen und führt das Programm

aus.

Um zu zeigen, wie das funktioniert, sind hier die Komponenten von

PATH aufgelistet, eine pro Zeile:

AUSGABE

/Users/vlad/bin

/usr/local/git/bin

/usr/bin

/bin

/usr/sbin

/sbin

/usr/local/binAuf unserem Computer gibt es eigentlich drei Programme namens

analyze in drei verschiedenen Verzeichnissen:

/bin/analyze, /usr/local/bin/analyze, und

/users/vlad/analyze. Da die Shell die Verzeichnisse in der

Reihenfolge durchsucht, in der sie in PATH aufgelistet

sind, findet sie /bin/analyze zuerst und führt es aus.

Beachten Sie, dass sie das Programm /users/vlad/analyze

nie finden wird, es sei denn, wir geben den vollständigen Pfad

zum Programm ein, da das Verzeichnis /users/vlad nicht in

PATH enthalten ist.

Das bedeutet, dass ich ausführbare Dateien an vielen verschiedenen

Orten haben kann, solange ich daran denke, dass ich mein

PATH aktualisieren muss, damit meine Shell sie finden

kann.

Was ist, wenn ich zwei verschiedene Versionen desselben Programms

ausführen möchte? Da sie den gleichen Namen haben, wird, wenn ich sie

beide zu meinem PATH hinzufüge, immer die erste gefundene

Version gewinnen. In der nächsten Folge werden wir lernen, wie wir

Hilfsmittel verwenden können, die uns bei der Verwaltung unserer

Laufzeitumgebung helfen, damit dies möglich ist, ohne dass wir eine

Menge Buchhaltung darüber führen müssen, welchen Wert PATH

(und andere wichtige Umgebungsvariablen) haben oder haben sollten.

- Shell-Variablen werden standardmäßig als Zeichenketten behandelt

- Variablen werden mit “

=” zugewiesen und mit dem Variablennamen, dem “$” vorangestellt ist, abgerufen - Verwenden Sie “

export”, um eine Variable für andere Programme verfügbar zu machen - Die Variable

PATHdefiniert den Suchpfad der Shell

Content from Zugriff auf Software über Module

Zuletzt aktualisiert am 2026-01-15 | Diese Seite bearbeiten

Übersicht

Fragen

- Wie laden und entladen wir Softwarepakete?

Ziele

- Ein Softwarepaket laden und verwenden.

- Erklären Sie, wie sich die Shell-Umgebung verändert, wenn der Modulmechanismus Pakete lädt oder entlädt.

Auf einem Hochleistungsrechnersystem ist die Software, die wir benutzen wollen, selten verfügbar, wenn wir uns anmelden. Sie ist zwar installiert, aber wir müssen sie erst “laden”, bevor sie ausgeführt werden kann.

Bevor wir jedoch anfangen, einzelne Softwarepakete zu verwenden, sollten wir die Gründe für diesen Ansatz verstehen. Die drei wichtigsten Faktoren sind:

- Software-Inkompatibilitäten

- Versionierung

- Abhängigkeiten

Software-Inkompatibilität ist ein großes Problem für Programmierer.

Manchmal führt das Vorhandensein (oder Fehlen) eines Softwarepakets

dazu, dass andere Pakete, die davon abhängen, nicht mehr funktionieren.

Zwei bekannte Beispiele sind Python und C-Compiler-Versionen. Python 3

bietet bekanntlich einen python-Befehl, der im Widerspruch

zu dem von Python 2 steht. Software, die mit einer neueren Version der

C-Bibliotheken kompiliert und dann auf einem Rechner ausgeführt wird,

auf dem ältere C-Bibliotheken installiert sind, führt zu einem

unangenehmen 'GLIBCXX_3.4.20' not found-Fehler.

Software Versionierung ist ein weiteres häufiges Problem. Ein Team könnte für sein Forschungsprojekt auf eine bestimmte Paketversion angewiesen sein - wenn sich die Softwareversion ändert (z.B. wenn ein Paket aktualisiert wird), könnte dies die Ergebnisse beeinflussen. Durch den Zugriff auf mehrere Softwareversionen kann eine Gruppe von Forschern verhindern, dass Softwareversionsprobleme ihre Ergebnisse beeinträchtigen.

Von Abhängigkeiten spricht man, wenn ein bestimmtes Softwarepaket (oder sogar eine bestimmte Version) vom Zugriff auf ein anderes Softwarepaket (oder sogar eine bestimmte Version eines anderen Softwarepakets) abhängig ist. Zum Beispiel kann die VASP-Materialwissenschaftssoftware davon abhängen, dass eine bestimmte Version der FFTW-Softwarebibliothek (Fastest Fourier Transform in the West) verfügbar ist, damit sie funktioniert.

Umgebungsmodule

Umgebungsmodule sind die Lösung für diese Probleme. Ein Modul ist eine in sich geschlossene Beschreibung eines Softwarepakets - es enthält die Einstellungen, die zum Ausführen eines Softwarepakets erforderlich sind, und kodiert in der Regel auch die erforderlichen Abhängigkeiten von anderen Softwarepaketen.

Es gibt eine Reihe von verschiedenen Implementierungen von

Umgebungsmodulen, die häufig auf HPC-Systemen verwendet werden: die

beiden häufigsten sind TCL-Module und Lmod. Beide

verwenden eine ähnliche Syntax und die Konzepte sind die gleichen, so

dass Sie, wenn Sie lernen, eines davon zu verwenden, dasjenige verwenden

können, das auf dem von Ihnen verwendeten System installiert ist. In

beiden Implementierungen wird der Befehl module verwendet,

um mit Umgebungsmodulen zu interagieren. Normalerweise wird dem Befehl

ein zusätzlicher Unterbefehl hinzugefügt, um anzugeben, was Sie tun

wollen. Für eine Liste von Unterbefehlen können Sie

module -h oder module help verwenden. Wie für

alle Befehle können Sie die vollständige Hilfe auf den

man-Seiten mit man module aufrufen.

Bei der Anmeldung können Sie mit einem Standardsatz von geladenen Modulen oder mit einer leeren Umgebung starten; dies hängt von der Einrichtung des von Ihnen verwendeten Systems ab.

Auflistung der verfügbaren Module

Um verfügbare Softwaremodule zu sehen, verwenden Sie

module avail:

AUSGABE

~~~ /cvmfs/pilot.eessi-hpc.org/2020.12/software/x86_64/amd/zen2/modules/all ~~~

Bazel/3.6.0-GCCcore-x.y.z NSS/3.51-GCCcore-x.y.z

Bison/3.5.3-GCCcore-x.y.z Ninja/1.10.0-GCCcore-x.y.z

Boost/1.72.0-gompi-2020a OSU-Micro-Benchmarks/5.6.3-gompi-2020a

CGAL/4.14.3-gompi-2020a-Python-3.x.y OpenBLAS/0.3.9-GCC-x.y.z

CMake/3.16.4-GCCcore-x.y.z OpenFOAM/v2006-foss-2020a

[removed most of the output here for clarity]

Where:

L: Module is loaded

Aliases: Aliases exist: foo/1.2.3 (1.2) means that "module load foo/1.2"

will load foo/1.2.3

D: Default Module

Use "module spider" to find all possible modules and extensions.

Use "module keyword key1 key2 ..." to search for all possible modules matching

any of the "keys".Laden und Entladen von Software

Um ein Softwaremodul zu laden, verwenden Sie

module load. In diesem Beispiel werden wir Python 3

verwenden.

Anfangs ist Python 3 nicht geladen. Wir können dies mit dem Befehl

which testen. der Befehl which sucht auf die

gleiche Weise wie die Bash nach Programmen, so dass wir ihn verwenden

können, um uns zu sagen, wo eine bestimmte Software gespeichert ist.

Wenn der Befehl python3 nicht verfügbar wäre, würden wir

folgende Ausgabe sehen

AUSGABE

/usr/bin/which: no python3 in (/cvmfs/pilot.eessi-hpc.org/2020.12/compat/linux/x86_64/usr/bin:/opt/software/slurm/bin:/usr/local/bin:/usr/bin:/usr/local/sbin:/usr/sbin:/opt/puppetlabs/bin:/home/yourUsername/.local/bin:/home/yourUsername/bin)Beachten Sie, dass dieser Text in Wirklichkeit eine Liste ist, mit

Werten, die durch das Zeichen : getrennt sind. Die Ausgabe

sagt uns, dass der Befehl which die folgenden Verzeichnisse

nach python3 durchsucht hat, ohne Erfolg:

AUSGABE

/cvmfs/pilot.eessi-hpc.org/2020.12/compat/linux/x86_64/usr/bin

/opt/software/slurm/bin

/usr/local/bin

/usr/bin

/usr/local/sbin

/usr/sbin

/opt/puppetlabs/bin

/home/yourUsername/.local/bin

/home/yourUsername/binIn unserem Fall haben wir jedoch ein vorhandenes python3

zur Verfügung, so dass wir sehen

AUSGABE

/cvmfs/pilot.eessi-hpc.org/2020.12/compat/linux/x86_64/usr/bin/python3Wir benötigen jedoch ein anderes Python als das vom System bereitgestellte, also laden wir ein Modul, um darauf zuzugreifen.

Wir können den Befehl python3 mit

module load laden:

AUSGABE

/cvmfs/pilot.eessi-hpc.org/2020.12/software/x86_64/amd/zen2/software/Python/3.x.y-GCCcore-x.y.z/bin/python3Was ist gerade passiert?

Um die Ausgabe zu verstehen, müssen wir zuerst die Natur der

Umgebungsvariablen $PATH verstehen. $PATH ist

eine spezielle Umgebungsvariable, die steuert, wo ein UNIX-System nach

Software sucht. Genauer gesagt ist $PATH eine Liste von

Verzeichnissen (getrennt durch :), die das Betriebssystem

nach einem Befehl durchsucht, bevor es aufgibt und uns mitteilt, dass es

ihn nicht finden kann. Wie bei allen Umgebungsvariablen können wir sie

mit echo ausgeben.

AUSGABE

/cvmfs/pilot.eessi-hpc.org/2020.12/software/x86_64/amd/zen2/software/Python/3.x.y-GCCcore-x.y.z/bin:/cvmfs/pilot.eessi-hpc.org/2020.12/software/x86_64/amd/zen2/software/SQLite/3.31.1-GCCcore-x.y.z/bin:/cvmfs/pilot.eessi-hpc.org/2020.12/software/x86_64/amd/zen2/software/Tcl/8.6.10-GCCcore-x.y.z/bin:/cvmfs/pilot.eessi-hpc.org/2020.12/software/x86_64/amd/zen2/software/GCCcore/x.y.z/bin:/cvmfs/pilot.eessi-hpc.org/2020.12/compat/linux/x86_64/usr/bin:/opt/software/slurm/bin:/usr/local/bin:/usr/bin:/usr/local/sbin:/usr/sbin:/opt/puppetlabs/bin:/home/user01/.local/bin:/home/user01/binSie werden eine Ähnlichkeit mit der Ausgabe des Befehls

which feststellen. In diesem Fall gibt es nur einen

Unterschied: das andere Verzeichnis am Anfang. Als wir den Befehl

module load ausführten, fügte er ein Verzeichnis am Anfang

unseres $PATH hinzu. Schauen wir uns an, was dort

steht:

BASH

[yourUsername@login1 ~] ls /cvmfs/pilot.eessi-hpc.org/2020.12/software/x86_64/amd/zen2/software/Python/3.x.y-GCCcore-x.y.z/binAUSGABE

2to3 nosetests-3.8 python rst2s5.py

2to3-3.8 pasteurize python3 rst2xetex.py

chardetect pbr python3.8 rst2xml.py

cygdb pip python3.8-config rstpep2html.py

cython pip3 python3-config runxlrd.py

cythonize pip3.8 rst2html4.py sphinx-apidoc

easy_install pybabel rst2html5.py sphinx-autogen

easy_install-3.8 __pycache__ rst2html.py sphinx-build

futurize pydoc3 rst2latex.py sphinx-quickstart

idle3 pydoc3.8 rst2man.py tabulate

idle3.8 pygmentize rst2odt_prepstyles.py virtualenv

netaddr pytest rst2odt.py wheel

nosetests py.test rst2pseudoxml.pyUm es auf den Punkt zu bringen: module load fügt

Software zu Ihrem $PATH hinzu. Es “lädt” Software. Ein

spezieller Hinweis dazu - je nachdem, welche Version des Programms

module bei Ihnen installiert ist, wird

module load auch erforderliche Software-Abhängigkeiten

laden.

Zur Veranschaulichung wollen wir module list verwenden.

module list zeigt alle geladenen Softwaremodule an.

AUSGABE

Currently Loaded Modules:

1) GCCcore/x.y.z 4) GMP/6.2.0-GCCcore-x.y.z

2) Tcl/8.6.10-GCCcore-x.y.z 5) libffi/3.3-GCCcore-x.y.z

3) SQLite/3.31.1-GCCcore-x.y.z 6) Python/3.x.y-GCCcore-x.y.zAUSGABE

Currently Loaded Modules:

1) GCCcore/x.y.z 14) libfabric/1.11.0-GCCcore-x.y.z

2) Tcl/8.6.10-GCCcore-x.y.z 15) PMIx/3.1.5-GCCcore-x.y.z

3) SQLite/3.31.1-GCCcore-x.y.z 16) OpenMPI/4.0.3-GCC-x.y.z

4) GMP/6.2.0-GCCcore-x.y.z 17) OpenBLAS/0.3.9-GCC-x.y.z

5) libffi/3.3-GCCcore-x.y.z 18) gompi/2020a

6) Python/3.x.y-GCCcore-x.y.z 19) FFTW/3.3.8-gompi-2020a

7) GCC/x.y.z 20) ScaLAPACK/2.1.0-gompi-2020a

8) numactl/2.0.13-GCCcore-x.y.z 21) foss/2020a

9) libxml2/2.9.10-GCCcore-x.y.z 22) pybind11/2.4.3-GCCcore-x.y.z-Pytho...

10) libpciaccess/0.16-GCCcore-x.y.z 23) SciPy-bundle/2020.03-foss-2020a-Py...

11) hwloc/2.2.0-GCCcore-x.y.z 24) networkx/2.4-foss-2020a-Python-3.8...

12) libevent/2.1.11-GCCcore-x.y.z 25) GROMACS/2020.1-foss-2020a-Python-3...

13) UCX/1.8.0-GCCcore-x.y.zIn diesem Fall hat das Laden des Moduls GROMACS (ein

Bioinformatik-Softwarepaket) auch GMP/6.2.0-GCCcore-x.y.z

und SciPy-bundle/2020.03-foss-2020a-Python-3.x.y geladen.

Lassen Sie uns versuchen, das Paket GROMACS zu

entladen.

AUSGABE

Currently Loaded Modules:

1) GCCcore/x.y.z 13) UCX/1.8.0-GCCcore-x.y.z

2) Tcl/8.6.10-GCCcore-x.y.z 14) libfabric/1.11.0-GCCcore-x.y.z

3) SQLite/3.31.1-GCCcore-x.y.z 15) PMIx/3.1.5-GCCcore-x.y.z

4) GMP/6.2.0-GCCcore-x.y.z 16) OpenMPI/4.0.3-GCC-x.y.z

5) libffi/3.3-GCCcore-x.y.z 17) OpenBLAS/0.3.9-GCC-x.y.z

6) Python/3.x.y-GCCcore-x.y.z 18) gompi/2020a

7) GCC/x.y.z 19) FFTW/3.3.8-gompi-2020a

8) numactl/2.0.13-GCCcore-x.y.z 20) ScaLAPACK/2.1.0-gompi-2020a

9) libxml2/2.9.10-GCCcore-x.y.z 21) foss/2020a

10) libpciaccess/0.16-GCCcore-x.y.z 22) pybind11/2.4.3-GCCcore-x.y.z-Pytho...

11) hwloc/2.2.0-GCCcore-x.y.z 23) SciPy-bundle/2020.03-foss-2020a-Py...

12) libevent/2.1.11-GCCcore-x.y.z 24) networkx/2.4-foss-2020a-Python-3.x.yDie Verwendung von module unload “entlädt” also ein

Modul, und je nachdem, wie eine Site konfiguriert ist, kann es auch alle

Abhängigkeiten entladen (in unserem Fall nicht). Wenn wir alles auf

einmal entladen wollten, könnten wir module purge ausführen

(entlädt alles).

AUSGABE

No modules loadedBeachten Sie, dass module purge informativ ist. Es teilt

uns auch mit, ob ein Standardsatz von “anhaftenden” (“sticky”) Paketen

nicht entladen werden kann (und wie man diese tatsächlich entlädt, wenn

man das wirklich möchte).

Beachten Sie, dass dieser Modulladeprozess hauptsächlich durch die

Manipulation von Umgebungsvariablen wie $PATH erfolgt.

Normalerweise ist nur ein geringer oder gar kein Datentransfer

beteiligt.

Der Modulladeprozess manipuliert auch andere spezielle Umgebungsvariablen, einschließlich Variablen, die beeinflussen, wo das System nach Softwarebibliotheken sucht, und manchmal Variablen, die kommerziellen Softwarepaketen mitteilen, wo sie Lizenzserver finden.

Der Modulbefehl setzt auch diese Shell-Umgebungsvariablen in ihren vorherigen Zustand zurück, wenn ein Modul entladen wird.

Software-Versionierung

Bis jetzt haben wir gelernt, wie man Softwarepakete lädt und entlädt. Das ist sehr nützlich. Wir haben uns jedoch noch nicht mit dem Thema der Softwareversionierung befasst. Irgendwann werden Sie auf Probleme stoßen, für die nur eine bestimmte Version einer Software geeignet ist. Vielleicht wurde ein wichtiger Fehler nur in einer bestimmten Version behoben, oder Version X ist nicht mehr mit einem von Ihnen verwendeten Dateiformat kompatibel. In jedem dieser Fälle ist es hilfreich, sehr genau zu wissen, welche Software geladen wird.

Schauen wir uns die Ausgabe von module avail näher

an.

AUSGABE

~~~ /cvmfs/pilot.eessi-hpc.org/2020.12/software/x86_64/amd/zen2/modules/all ~~~

Bazel/3.6.0-GCCcore-x.y.z NSS/3.51-GCCcore-x.y.z

Bison/3.5.3-GCCcore-x.y.z Ninja/1.10.0-GCCcore-x.y.z

Boost/1.72.0-gompi-2020a OSU-Micro-Benchmarks/5.6.3-gompi-2020a

CGAL/4.14.3-gompi-2020a-Python-3.x.y OpenBLAS/0.3.9-GCC-x.y.z

CMake/3.16.4-GCCcore-x.y.z OpenFOAM/v2006-foss-2020a

[removed most of the output here for clarity]

Where:

L: Module is loaded

Aliases: Aliases exist: foo/1.2.3 (1.2) means that "module load foo/1.2"

will load foo/1.2.3

D: Default Module

Use "module spider" to find all possible modules and extensions.

Use "module keyword key1 key2 ..." to search for all possible modules matching

any of the "keys".Verwendung von Software-Modulen in Skripten

Erstellen Sie einen Job, der in der Lage ist,

python3 --version auszuführen. Denken Sie daran, dass

standardmäßig keine Software geladen ist! Das Ausführen eines Jobs ist

genau wie das Anmelden am System (Sie sollten nicht davon ausgehen, dass

ein auf dem Anmeldeknoten geladenes Modul auch auf einem Rechenknoten

geladen ist).

- Software mit

module load softwareNameladen. - Entladen von Software mit

module unload - Das Modulsystem kümmert sich automatisch um Softwareversionen und Paketkonflikte.

Content from Übertragen von Dateien mit remote Computern

Zuletzt aktualisiert am 2026-01-15 | Diese Seite bearbeiten

Übersicht

Fragen

- Wie übertrage ich Dateien zum (und vom) Cluster?

Ziele

- Übertragen Sie Dateien zu und von einem Computer-Cluster.

Die Arbeit auf einem remote Computer ist nicht sehr nützlich, wenn wir keine Dateien zum oder vom Cluster bekommen können. Es gibt mehrere Optionen für die Übertragung von Daten zwischen Computerressourcen mit Hilfe von CLI- und GUI-Dienstprogrammen, von denen wir einige vorstellen werden.

Herunterladen von Lektionsdateien aus dem Internet

Einer der einfachsten Wege, Dateien herunterzuladen, ist die

Verwendung von curl oder wget. Eines von