Content from Perché usare un cluster?

Ultimo aggiornamento il 2026-01-15 | Modifica questa pagina

Panoramica

Domande

- Perché dovrei essere interessato al calcolo ad alte prestazioni (HPC)?

- Cosa posso aspettarmi di imparare da questo corso?

Obiettivi

- Descrivere che cos’è un sistema HPC

- Identificare i vantaggi di un sistema HPC.

Spesso i problemi di ricerca che utilizzano l’informatica possono superare le capacità del computer desktop o portatile da cui sono partiti:

- Uno studente di statistica vuole effettuare una convalida incrociata di un modello. Ciò comporta l’esecuzione del modello 1000 volte, ma ogni esecuzione richiede un’ora. L’esecuzione del modello su un computer portatile richiede più di un mese! In questo problema di ricerca, i risultati finali vengono calcolati dopo l’esecuzione di tutti i 1000 modelli, ma in genere viene eseguito solo un modello alla volta (in serie) sul portatile. Poiché ognuna delle 1000 esecuzioni è indipendente da tutte le altre, e con un numero sufficiente di computer, è teoricamente possibile eseguirle tutte insieme (in parallelo).

- Un ricercatore di genomica ha utilizzato piccoli insiemi di dati di sequenza, ma presto riceverà un nuovo tipo di dati di sequenziamento 10 volte più grandi. Aprire i set di dati su un computer è già impegnativo, analizzare questi set di dati più grandi probabilmente lo manderà in tilt. In questo problema di ricerca, i calcoli richiesti potrebbero essere impossibili da parallelizzare, ma sarebbe necessario un computer con più memoria per analizzare i futuri set di dati molto più grandi.

- Un ingegnere sta usando un pacchetto di fluidodinamica che ha un’opzione per l’esecuzione in parallelo. Finora questa opzione non è stata utilizzata su un desktop. Passando dalle simulazioni 2D a quelle 3D, il tempo di simulazione è più che triplicato. Potrebbe essere utile sfruttare questa opzione o funzione. In questo problema di ricerca, i calcoli in ogni regione della simulazione sono ampiamente indipendenti dai calcoli in altre regioni della simulazione. È possibile eseguire i calcoli di ogni regione simultaneamente (in parallelo), comunicare i risultati selezionati alle regioni adiacenti, se necessario, e ripetere i calcoli per convergere su un insieme finale di risultati. Passando da un modello 2D a uno 3D, la quantità di dati e di calcoli aumenta notevolmente, ed è teoricamente possibile distribuire i calcoli su più computer che comunicano su una rete condivisa.

In tutti questi casi, è necessario l’accesso a più computer. Questi computer dovrebbero essere utilizzabili contemporaneamente, risolvendo in parallelo i problemi di molti ricercatori.

Presentazione del gergo

Aprire HPC Jargon Buster in una nuova

scheda. Per presentare il contenuto, premere C per aprire

una clone in una finestra separata, quindi premere

P per attivare la modalità di

presentazione.

Avete mai usato un server?

Prendete un minuto e pensate a quali delle vostre interazioni quotidiane con un computer potrebbero richiedere un server remoto o addirittura un cluster per fornirvi i risultati.

- Controllo della posta elettronica: il vostro computer (magari in tasca) contatta una macchina remota, si autentica e scarica un elenco di nuovi messaggi; carica anche le modifiche allo stato dei messaggi, come ad esempio se sono stati letti, contrassegnati come spazzatura o cancellati. Poiché il vostro non è l’unico account, il server di posta è probabilmente uno dei tanti in un centro dati.

- La ricerca di una frase online comporta il confronto del termine di ricerca con un enorme database di tutti i siti conosciuti, alla ricerca di corrispondenze. Questa operazione di “interrogazione” può essere semplice, ma la costruzione del database è un compito monumentale! I server sono coinvolti in ogni fase.

- La ricerca di indicazioni stradali su un sito web di mappatura comporta il collegamento dei punti (A) di partenza e (B) di arrivo attraversando un grafo alla ricerca del percorso “più breve” in base alla distanza, al tempo, alla spesa o a un’altra metrica. Convertire una mappa nella forma corretta è relativamente semplice, ma calcolare tutti i possibili percorsi tra A e B è costoso.

Il controllo della posta elettronica potrebbe essere seriale: la macchina si connette a un server e scambia dati. Anche la ricerca, interrogando il database per il termine di ricerca (o gli endpoint), potrebbe essere seriale, in quanto una macchina riceve l’interrogazione e restituisce il risultato. Tuttavia, l’assemblaggio e la memorizzazione dell’intero database vanno ben oltre le capacità di una sola macchina. Pertanto, queste funzioni vengono svolte in parallelo da una vasta collezione di server “hyperscale” che lavorano insieme.

- Il calcolo ad alte prestazioni (HPC) comporta tipicamente la connessione a sistemi di calcolo molto grandi in altre parti del mondo.

- Questi altri sistemi possono essere utilizzati per eseguire lavori che sarebbero impossibili o molto più lenti su sistemi più piccoli.

- Le risorse HPC sono condivise da più utenti.

- Il metodo standard di interazione con questi sistemi è tramite un’interfaccia a riga di comando.

Content from Connessione a un sistema HPC remoto

Ultimo aggiornamento il 2026-01-15 | Modifica questa pagina

Panoramica

Domande

- Come si accede a un sistema HPC remoto?

Obiettivi

- Configurare l’accesso sicuro a un sistema HPC remoto.

- Connessione a un sistema HPC remoto.

Connessioni sicure

Il primo passo per utilizzare un cluster è stabilire una connessione dal nostro portatile al cluster. Quando siamo seduti davanti a un computer (o in piedi, o tenendolo in mano o al polso), ci aspettiamo una visualizzazione con icone, widget e forse alcune finestre o applicazioni: una interfaccia utente grafica, o GUI. Poiché i cluster di computer sono risorse remote a cui ci si connette tramite interfacce lente o intermittenti (soprattutto WiFi e VPN), è più pratico utilizzare una interfaccia a riga di comando, o CLI, per inviare comandi in testo semplice. Se un comando restituisce un output, anche questo viene stampato come testo normale. I comandi che eseguiamo oggi non apriranno una finestra per mostrare i risultati grafici.

Se avete mai aperto il Prompt dei comandi di Windows o il Terminale di macOS, avete visto una CLI. Se avete già seguito i corsi di The Carpentries sulla shell UNIX o sul controllo di versione, avete usato ampiamente la CLI sulla vostra macchina locale. L’unico salto da fare in questo caso è aprire una CLI su una macchina remota, prendendo alcune precauzioni in modo che gli altri utenti della rete non possano vedere (o modificare) i comandi che state eseguendo o i risultati che la macchina remota invia. Utilizzeremo il protocollo Secure SHell (o SSH) per aprire una connessione di rete crittografata tra due macchine, consentendovi di inviare e ricevere testo e dati senza dovervi preoccupare di occhi indiscreti.

I client SSH sono solitamente strumenti a riga di comando, in cui si

fornisce l’indirizzo della macchina remota come unico argomento

richiesto. Se il nome utente sul sistema remoto è diverso da quello

utilizzato localmente, è necessario fornire anche quello. Se il vostro

client SSH ha un front-end grafico, come PuTTY o MobaXterm, dovrete

impostare questi argomenti prima di fare clic su “connect” Dal

terminale, si scriverà qualcosa come ssh userName@hostname,

dove l’argomento è proprio come un indirizzo e-mail: il simbolo “@” è

usato per separare l’ID personale dall’indirizzo della macchina

remota.

Quando si accede a un computer portatile, a un tablet o a un altro dispositivo personale, di solito sono necessari un nome utente, una password o un modello per impedire l’accesso non autorizzato. In queste situazioni, la probabilità che qualcun altro intercetti la password è bassa, poiché la registrazione dei tasti premuti richiede un exploit dannoso o un accesso fisico. Per i sistemi come login1’ che eseguono un server SSH, chiunque sulla rete può accedere, o tentare di farlo. Poiché i nomi utente sono spesso pubblici o facili da indovinare, la password è spesso l’anello più debole della catena di sicurezza. Per questo motivo, molti cluster vietano il login basato su password, richiedendo invece di generare e configurare una coppia di chiavi pubbliche e private con una password molto più forte. Anche se il vostro cluster non lo richiede, la prossima sezione vi guiderà nell’uso delle chiavi SSH e di un agente SSH per rafforzare la vostra sicurezza e rendere più conveniente l’accesso ai sistemi remoti.

Migliore sicurezza con le chiavi SSH

Il Lesson Setup fornisce le istruzioni per installare un’applicazione shell con SSH. Se non l’avete già fatto, aprite l’applicazione di shell con un’interfaccia a riga di comando di tipo Unix sul vostro sistema.

Le chiavi SSH sono un metodo alternativo di autenticazione per ottenere l’accesso a sistemi informatici remoti. Possono anche essere usate per l’autenticazione durante il trasferimento di file o per accedere a sistemi di controllo di versione remoti (come GitHub). In questa sezione verrà creata una coppia di chiavi SSH:

- una chiave privata che si conserva sul proprio computer e

- una chiave pubblica che può essere inserita in qualsiasi sistema remoto a cui si accede.

Le chiavi private sono il vostro passaporto digitale sicuro

Una chiave privata visibile a chiunque tranne che a voi deve essere considerata compromessa e deve essere distrutta. Questo include avere permessi impropri sulla directory in cui è memorizzata (o una sua copia), attraversare una rete non sicura (crittografata), allegare e-mail non crittografate e persino visualizzare la chiave nella finestra del terminale.

Proteggete questa chiave come se vi aprisse la porta di casa. Per molti versi, è così.

Indipendentemente dal software o dal sistema operativo utilizzato, vi preghiamo di scegliere una password o una passphrase forte che funga da ulteriore livello di protezione per la chiave SSH privata.

Considerazioni sulle password delle chiavi SSH

Quando viene richiesto, inserire una password forte che si ricordi. Esistono due approcci comuni:

- Creare una passphrase memorabile con punteggiatura e sostituzioni di numeri con lettere, di almeno 32 caratteri. Gli indirizzi stradali funzionano bene; fate attenzione agli attacchi di social engineering o ai registri pubblici.

- Utilizzare un gestore di password e il suo generatore di password integrato con tutte le classi di caratteri, a partire da 25 caratteri. KeePass e BitWarden sono due buone opzioni.

- Nulla è meno sicuro di una chiave privata senza password. Se per sbaglio avete saltato l’inserimento della password, tornate indietro e generate una nuova coppia di chiavi con una password forte.

Chiavi SSH su Linux, Mac, MobaXterm e Windows Sottosistema per Linux

Una volta aperto il terminale, verificare la presenza di chiavi SSH e nomi di file esistenti, poiché le chiavi SSH esistenti vengono sovrascritte.

se ~/.ssh/id_ed25519 esiste già, è necessario

specificare un nome diverso per la nuova coppia di chiavi.

Generare una nuova coppia di chiavi pubbliche e private usando il

seguente comando, che produrrà una chiave più forte di quella

predefinita ssh-keygen invocando questi flag:

-

-a(il valore predefinito è 16): numero di cicli di derivazione della passphrase; aumentare per rallentare gli attacchi brute force. -

-t(l’impostazione predefinita è rsa): specifica il “tipo” o algoritmo crittografico.ed25519specifica EdDSA con una chiave a 256 bit; è più veloce di RSA con una forza comparabile. -

-f(predefinito è /home/user/.ssh/id): nome del file in cui memorizzare la chiave privata. Il nome del file della chiave pubblica sarà identico, con l’aggiunta dell’estensione.pub.

Quando viene richiesto, inserire una password forte tenendo conto delle considerazioni precedenti. Si noti che il terminale non sembra cambiare mentre si digita la password: questo è intenzionale, per la vostra sicurezza. Vi verrà richiesto di digitarla di nuovo, quindi non preoccupatevi troppo degli errori di battitura.

Guardare in ~/.ssh (usare ls ~/.ssh). Si

dovrebbero vedere due nuovi file:

- la vostra chiave privata (

~/.ssh/id_ed25519): *non condividere con nessuno! - la chiave pubblica condivisibile

(

~/.ssh/id_ed25519.pub): se un amministratore di sistema chiede una chiave, questa è quella da inviare. È anche sicura da caricare su siti web come GitHub: è destinata a essere vista.

Usa RSA per i sistemi più vecchi

Se la generazione della chiave non è riuscita perché ed25519 non è disponibile, provare a usare il più vecchio (ma ancora forte e affidabile) crittosistema RSA. Anche in questo caso, verificare prima la presenza di una chiave esistente:

Se ~/.ssh/id_rsa esiste già, è necessario specificare un

nome diverso per la nuova coppia di chiavi. Generarla come sopra, con i

seguenti flag aggiuntivi:

-

-bimposta il numero di bit della chiave. L’impostazione predefinita è 2048. EdDSA utilizza una lunghezza fissa della chiave, quindi questo flag non ha alcun effetto. -

-o(nessun valore predefinito): utilizzare il formato della chiave OpenSSH, anziché PEM.

Quando viene richiesto, inserire una password forte tenendo conto delle considerazioni di cui sopra.

Guardare in ~/.ssh (usare ls ~/.ssh). Si

dovrebbero vedere due nuovi file:

- la vostra chiave privata (

~/.ssh/id_rsa): *non condividere con nessuno! - la chiave pubblica condivisibile (

~/.ssh/id_rsa.pub): se un amministratore di sistema chiede una chiave, questa è quella da inviare. È anche sicura da caricare su siti web come GitHub: è destinata a essere vista.

Chiavi SSH su PuTTY

Se si usa PuTTY su Windows, scaricare e usare puttygen

per generare la coppia di chiavi. Vedere la documentazione

di PuTTY per i dettagli.

- Selezionare

EdDSAcome tipo di chiave. - Selezionare

255come dimensione o forza della chiave. - Fare clic sul pulsante “Genera”.

- Non è necessario inserire un commento.

- Quando viene richiesto, inserire una password forte tenendo conto delle considerazioni di cui sopra.

- Salvare le chiavi in una cartella che non può essere letta da altri utenti del sistema.

Guardare nella cartella specificata. Si dovrebbero vedere due nuovi file:

- la vostra chiave privata (

id_ed25519): *non condividere con nessuno! - la chiave pubblica condivisibile (

id_ed25519.pub): se un amministratore di sistema chiede una chiave, questa è quella da inviare. È anche sicura da caricare su siti web come GitHub: è destinata a essere vista.

Agente SSH per una gestione delle chiavi più semplice

Una chiave SSH è forte quanto la password usata per sbloccarla, ma d’altra parte digitare una password complessa ogni volta che ci si connette a una macchina è noioso e stufa molto velocemente. È qui che entra in gioco l’agente SSH.

Utilizzando un agente SSH, è possibile digitare una volta la password per la chiave privata e fare in modo che l’agente la ricordi per un certo numero di ore o finché non ci si disconnette. A meno che qualche malintenzionato non abbia accesso fisico al vostro computer, questo permette di mantenere la password al sicuro ed elimina la noia di doverla digitare più volte.

Ricordate la password, perché una volta scaduta nell’Agente, dovrete digitarla di nuovo.

Agenti SSH su Linux, macOS e Windows

Aprire l’applicazione terminale e verificare se è in esecuzione un agente:

-

Se si ottiene un errore come questo,

ERRORE

Error connecting to agent: No such file or directory… quindi è necessario lanciare l’agente come segue:

RichiamoCosa c’è in un

$(...)?La sintassi di questo comando dell’agente SSH è insolita, rispetto a quanto visto nella lezione sulla shell UNIX. Questo perché il comando

ssh-agentcrea una connessione a cui solo voi avete accesso e stampa una serie di comandi di shell che possono essere usati per raggiungerla, ma *non li esegue!OUTPUT

SSH_AUTH_SOCK=/tmp/ssh-Zvvga2Y8kQZN/agent.131521; export SSH_AUTH_SOCK; SSH_AGENT_PID=131522; export SSH_AGENT_PID; echo Agent pid 131522;Il comando

evalinterpreta l’output di testo come comandi e consente di accedere alla connessione dell’agente SSH appena creata.Si potrebbe eseguire da soli ogni riga dell’output di

ssh-agente ottenere lo stesso risultato. L’uso dievalrende tutto più semplice. In caso contrario, l’agente è già in esecuzione: non modificarlo.

Aggiungere la propria chiave all’agente, con scadenza della sessione dopo 8 ore:

OUTPUT

Enter passphrase for .ssh/id_ed25519:

Identity added: .ssh/id_ed25519

Lifetime set to 86400 secondsPer tutta la durata (8 ore), ogni volta che userete quella chiave, l’agente SSH fornirà la chiave per vostro conto senza che dobbiate digitare un solo tasto.

Agente SSH su PuTTY

Se si usa PuTTY su Windows, scaricare e usare pageant

come agente SSH. Vedere la documentazione

di PuTTY.

Accedere al cluster

Aprire il terminale o il client grafico SSH, quindi accedere al

cluster. Sostituire yourUsername con il proprio nome utente

o con quello fornito dagli istruttori.

potrebbe essere richiesta la password. Attenzione: i caratteri

digitati dopo la richiesta della password non vengono visualizzati sullo

schermo. L’output normale riprenderà quando si premerà

Enter.

Avrete notato che il prompt è cambiato quando vi siete collegati al

sistema remoto usando il terminale (se vi siete collegati con PuTTY

questo non vale perché non offre un terminale locale). Questo

cambiamento è importante perché può aiutare a distinguere su quale

sistema verranno eseguiti i comandi digitati quando li si passa al

terminale. Questa modifica rappresenta anche una piccola complicazione

che dovremo affrontare nel corso del workshop. L’esatta visualizzazione

del prompt (che convenzionalmente termina con $) nel

terminale quando è collegato al sistema locale e al sistema remoto sarà

in genere diversa per ogni utente. È comunque necessario indicare su

quale sistema si stanno inserendo i comandi, quindi adotteremo la

seguente convenzione:

-

[you@laptop:~]$quando il comando deve essere immesso su un terminale collegato al computer locale -

[yourUsername@login1 ~]quando il comando deve essere immesso su un terminale collegato al sistema remoto -

$quando non ha importanza a quale sistema sia collegato il terminale.

Guardando intorno alla vostra casa remota

Molto spesso, molti utenti sono tentati di pensare a un’installazione

di calcolo ad alte prestazioni come a una gigantesca macchina magica. A

volte si pensa che il computer a cui si accede sia l’intero cluster di

calcolo. Ma cosa sta succedendo davvero? A quale computer ci siamo

collegati? Il nome del computer correntemente collegato può essere

controllato con il comando hostname. (Si può anche notare

che il nome dell’host corrente fa parte del nostro prompt)

OUTPUT

login1Quindi, siamo sicuramente sul computer remoto. Quindi, scopriamo dove

ci troviamo eseguendo pwd per stampare la

cartella di lavoro d.

OUTPUT

/home/yourUsernameOttimo, sappiamo dove siamo! Vediamo cosa c’è nella nostra cartella corrente:

OUTPUT

id_ed25519.pubGli amministratori del sistema potrebbero aver configurato la vostra cartella home con alcuni file, cartelle e collegamenti (scorciatoie) utili allo spazio riservato a voi su altri filesystem. Se non l’hanno fatto, la cartella home potrebbe apparire vuota. Per ricontrollare, includere i file nascosti nell’elenco delle cartelle:

OUTPUT

. .bashrc id_ed25519.pub

.. .sshNella prima colonna, . è un riferimento alla directory

corrente e .. un riferimento alla cartella precedente

(/home). Gli altri file, o file simili, possono essere

visualizzati o meno: .bashrc è un file di configurazione

della shell, che può essere modificato con le proprie preferenze; e

.ssh è una directory che memorizza le chiavi SSH e un

registro delle connessioni autorizzate.

Installare la chiave SSH

Ci può essere un modo migliore

Le politiche e le pratiche per la gestione delle chiavi SSH variano tra i cluster HPC: seguire le indicazioni fornite dagli amministratori del cluster o la documentazione. In particolare, se esiste un portale online per la gestione delle chiavi SSH, utilizzare quello invece delle indicazioni qui riportate.

Se si è trasferita la chiave pubblica SSH con scp, si

dovrebbe vedere id_ed25519.pub nella propria home

directory. Per “installare” questa chiave, deve essere elencata in un

file chiamato authorized_keys sotto la cartella

.ssh.

Se la cartella .ssh non è stata elencata sopra, allora

non esiste ancora: bisogna crearla.

Ora, usare cat per stampare la chiave pubblica, ma

reindirizzare l’output, aggiungendolo al file

authorized_keys:

Tutto qui! Se la chiave e l’agente sono stati configurati correttamente, non dovrebbe essere richiesta la password per la chiave SSH.

- Un sistema HPC è un insieme di macchine collegate in rete.

- I sistemi HPC forniscono in genere nodi di accesso e una serie di nodi worker.

- Le risorse presenti sui nodi indipendenti (worker) possono variare per volume e tipo (quantità di RAM, architettura del processore, disponibilità di filesystem montati in rete, ecc.)

- I file salvati su un nodo sono disponibili su tutti i nodi.

Content from Lavorare su un sistema HPC remoto

Ultimo aggiornamento il 2026-01-15 | Modifica questa pagina

Panoramica

Domande

- “Che cos’è un sistema HPC?”

- “Come funziona un sistema HPC?”

- “Come si accede a un sistema HPC remoto?”

Obiettivi

- “Connettersi a un sistema HPC remoto”

- “Comprendere l’architettura generale del sistema HPC”

Cos’è un sistema HPC?

Le parole “cloud”, “cluster” e l’espressione “calcolo ad alte prestazioni” o “HPC” sono molto usate in contesti diversi e con vari significati correlati. Che cosa significano? E soprattutto, come li usiamo nel nostro lavoro?

Il cloud è un termine generico comunemente usato per riferirsi a risorse informatiche che sono a) fornite agli utenti su richiesta o in base alle necessità e b) rappresentano risorse reali o virtuali che possono essere situate ovunque sulla Terra. Ad esempio, una grande azienda con risorse informatiche in Brasile, Zimbabwe e Giappone può gestire tali risorse come un proprio cloud interno e la stessa azienda può anche utilizzare risorse cloud commerciali fornite da Amazon o Google. Le risorse cloud possono riferirsi a macchine che eseguono compiti relativamente semplici come servire siti web, fornire storage condiviso, fornire servizi web (come e-mail o piattaforme di social media), così come compiti più tradizionali ad alta intensità di calcolo come l’esecuzione di una simulazione.

Il termine sistema HPC, invece, descrive una risorsa indipendente per carichi di lavoro ad alta intensità di calcolo. In genere sono costituiti da una moltitudine di elementi integrati di elaborazione e archiviazione, progettati per gestire elevati volumi di dati e/o un gran numero di operazioni in virgola mobile (FLOPS) con le massime prestazioni possibili. Ad esempio, tutte le macchine presenti nell’elenco Top-500 sono sistemi HPC. Per supportare questi vincoli, una risorsa HPC deve esistere in una posizione specifica e fissa: i cavi di rete possono estendersi solo fino a un certo punto e i segnali elettrici e ottici possono viaggiare solo a una certa velocità.

La parola “cluster” è spesso usata per risorse HPC di scala piccola o moderata, meno impressionanti della Top-500. I cluster sono spesso gestiti in centri di calcolo che supportano diversi sistemi di questo tipo, tutti accomunati dalla condivisione di reti e storage per supportare attività comuni ad alta intensità di calcolo.

Registrazione

Il primo passo per utilizzare un cluster è stabilire una connessione dal nostro portatile al cluster. Quando siamo seduti al computer (o in piedi, o tenendolo in mano o al polso), ci aspettiamo una visualizzazione con icone, widget e forse alcune finestre o applicazioni: un’interfaccia grafica utente, o GUI. Poiché i cluster di computer sono risorse remote a cui ci colleghiamo tramite interfacce spesso lente o laggose (soprattutto WiFi e VPN), è più pratico utilizzare un’interfaccia a riga di comando (CLI), in cui i comandi e i risultati sono trasmessi solo tramite testo. Tutto ciò che non è testo (ad esempio le immagini) deve essere scritto su disco e aperto con un programma separato.

Se avete mai aperto il Prompt dei comandi di Windows o il Terminale di macOS, avete visto una CLI. Se avete già seguito i corsi di The Carpentries sulla shell UNIX o su git, avete usato la CLI sulla vostra macchina locale in modo piuttosto esteso. L’unico salto da fare in questo caso è aprire una CLI su una macchina remota, prendendo alcune precauzioni in modo che gli altri utenti della rete non possano vedere (o modificare) i comandi che state eseguendo o i risultati che la macchina remota invia. Utilizzeremo il protocollo Secure SHell (o SSH) per aprire una connessione di rete crittografata tra due macchine, consentendo di inviare e ricevere testo e dati senza doversi preoccupare di occhi indiscreti.

Assicurarsi di avere un client SSH installato sul portatile. Fare

riferimento alla sezione setup per maggiori

dettagli. I client SSH sono solitamente strumenti a riga di comando, in

cui si fornisce l’indirizzo della macchina remota come unico argomento

richiesto. Se il nome utente sul sistema remoto è diverso da quello

utilizzato localmente, è necessario fornire anche quello. Se il vostro

client SSH ha un front-end grafico, come PuTTY o MobaXterm, dovrete

impostare questi argomenti prima di fare clic su “connect” Dal

terminale, si scriverà qualcosa come ssh userName@hostname,

dove il simbolo “@” è usato per separare le due parti di un singolo

argomento.

Aprite il vostro terminale o il vostro client grafico SSH, quindi accedete al cluster usando il vostro nome utente e il computer remoto che potete raggiungere dal mondo esterno, cluster.hpc-carpentry.org.

Ricordarsi di sostituire yourUsername con il proprio

nome utente o con quello fornito dagli istruttori. Potrebbe essere

richiesta la password. Attenzione: i caratteri digitati dopo la

richiesta della password non vengono visualizzati sullo schermo.

L’output normale riprenderà quando si premerà Enter.

Dove siamo?

Molto spesso, molti utenti sono tentati di pensare a un’installazione

di calcolo ad alte prestazioni come a una gigantesca macchina magica. A

volte si pensa che il computer a cui si è acceduto sia l’intero cluster

di calcolo. Ma cosa sta succedendo davvero? A quale computer ci siamo

collegati? Il nome del computer correntemente collegato può essere

controllato con il comando hostname. (Si può anche notare

che il nome dell’host corrente fa parte del nostro prompt)

OUTPUT

login1Cosa c’è nella vostra directory principale?

Gli amministratori del sistema potrebbero aver configurato la vostra

cartella home con alcuni file, cartelle e collegamenti (scorciatoie)

utili allo spazio riservato a voi su altri filesystem. Date un’occhiata

in giro e vedete cosa riuscite a trovare. Suggerimento: I

comandi di shell pwd e ls possono essere

utili. Il contenuto della home directory varia da utente a utente.

Discutete con i vostri vicini le eventuali differenze riscontrate.

Il livello più profondo dovrebbe essere diverso:

yourUsername è unicamente vostro. Ci sono differenze nel

percorso ai livelli superiori?

se entrambi avete delle cartelle vuote, appariranno identiche. Se voi o il vostro vicino avete già usato il sistema, potrebbero esserci delle differenze. Su cosa state lavorando?

Usare pwd per stampare il percorso della

d**irettoria di lavoro:

è possibile eseguire ls per verificare il contenuto

della cartella, anche se è possibile che non venga visualizzato nulla

(se non sono stati forniti file). Per sicurezza, usare il flag

-a per mostrare anche i file nascosti.

come minimo, mostrerà la cartella corrente come . e la

cartella precedente come ...

Nodi

I singoli computer che compongono un cluster sono in genere chiamati nodi (anche se si sente parlare anche di server, computer e macchine). In un cluster, ci sono diversi tipi di nodi per diversi tipi di attività. Il nodo in cui ci si trova in questo momento è chiamato nodo principale, nodo di accesso, pista di atterraggio o nodo di invio. Un nodo di accesso serve come punto di accesso al cluster.

Come gateway, è adatto per caricare e scaricare file, configurare software ed eseguire test rapidi. In generale, il nodo di accesso non dovrebbe essere usato per attività che richiedono molto tempo o risorse. È necessario prestare attenzione a questo aspetto e verificare con i gestori del sito o con la documentazione i dettagli di ciò che è consentito o meno. In queste lezioni, eviteremo di eseguire lavori sul nodo principale.

Nodi di trasferimento dedicati

Se si desidera trasferire grandi quantità di dati da o verso il cluster, alcuni sistemi offrono nodi dedicati solo al trasferimento dei dati. La motivazione risiede nel fatto che i trasferimenti di dati più grandi non devono ostacolare il funzionamento del nodo di login per nessun altro. Verificate con la documentazione del vostro cluster o con il team di supporto se è disponibile un nodo di trasferimento di questo tipo. Come regola generale, si considerano grandi tutti i trasferimenti di un volume superiore a 500 MB e 1 GB. Ma questi numeri cambiano, ad esempio, a seconda della connessione di rete propria e del cluster o di altri fattori.

Il vero lavoro in un cluster viene svolto dai nodi di lavoro (o di calcolo*). I nodi worker sono di varie forme e dimensioni, ma in genere sono dedicati a compiti lunghi o difficili che richiedono molte risorse di calcolo.

Tutte le interazioni con i nodi worker sono gestite da un software specializzato chiamato scheduler (lo scheduler usato in questa lezione si chiama Slurm). In seguito impareremo a usare lo scheduler per inviare i lavori, ma per il momento è in grado di fornire ulteriori informazioni sui nodi worker.

Per esempio, possiamo visualizzare tutti i nodi worker eseguendo il

comando sinfo.

OUTPUT

PARTITION AVAIL TIMELIMIT NODES STATE NODELIST

cpubase_bycore_b1* up infinite 4 idle node[1-2],smnode[1-2]

node up infinite 2 idle node[1-2]

smnode up infinite 2 idle smnode[1-2]Ci sono anche macchine specializzate utilizzate per gestire lo storage del disco, l’autenticazione degli utenti e altri compiti legati all’infrastruttura. Sebbene in genere non ci si colleghi o si interagisca direttamente con queste macchine, esse consentono di svolgere una serie di funzioni chiave, come garantire che il nostro account utente e i nostri file siano disponibili in tutto il sistema HPC.

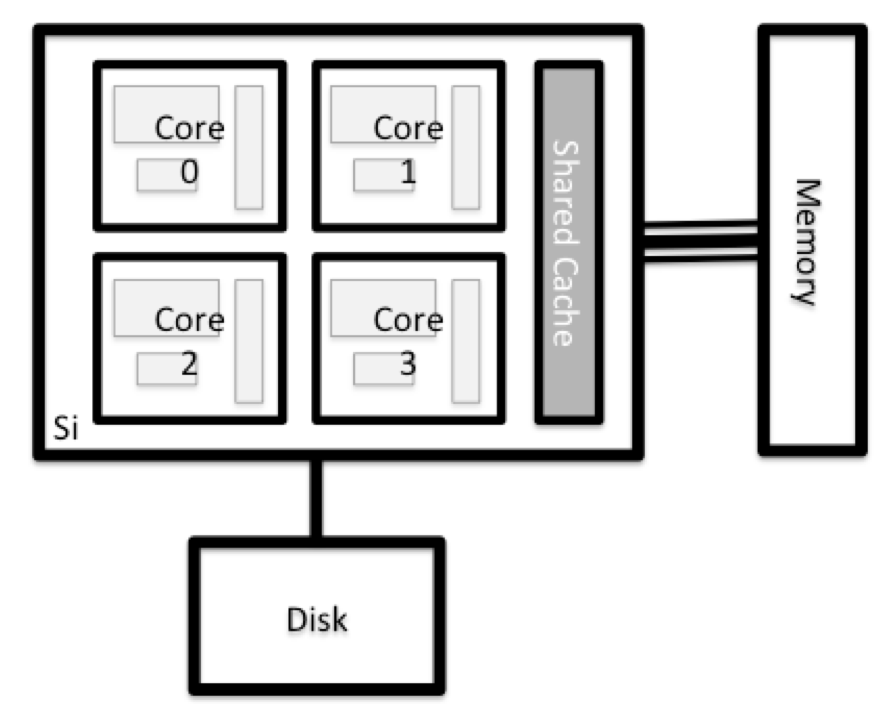

Cosa c’è in un nodo?

Tutti i nodi di un sistema HPC hanno gli stessi componenti del vostro laptop o desktop: CPU (talvolta chiamate anche processori o core), memoria (o RAM) e spazio su disco. Le CPU sono lo strumento del computer per eseguire programmi e calcoli. Le informazioni su un’attività corrente sono memorizzate nella memoria del computer. Il disco si riferisce a tutta la memoria a cui si può accedere come un file system. In genere si tratta di uno spazio di archiviazione che può contenere dati in modo permanente, vale a dire che i dati sono ancora presenti anche se il computer è stato riavviato. Anche se questa memoria può essere locale (un disco rigido installato al suo interno), è più comune che i nodi si colleghino a un fileserver condiviso e remoto o a un cluster di server.

Esplora il tuo computer

Ci sono diversi modi per farlo. La maggior parte dei sistemi operativi ha un monitor grafico di sistema, come il Task Manager di Windows. A volte è possibile trovare informazioni più dettagliate alla riga di comando. Ad esempio, alcuni dei comandi utilizzati su un sistema Linux sono:

Esecuzione delle utilità di sistema

Leggere da /proc

Utilizzare un monitor di sistema

Esplora il nodo di login

Ora confrontate le risorse del vostro computer con quelle del nodo principale.

BASH

[you@laptop:~]$ ssh yourUsername@cluster.hpc-carpentry.org

[yourUsername@login1 ~] nproc --all

[yourUsername@login1 ~] free -mÈ possibile ottenere maggiori informazioni sui processori utilizzando

lscpu, e molti dettagli sulla memoria leggendo il file

/proc/meminfo:

È anche possibile esplorare i filesystem disponibili usando

df per mostrare lo spazio disk

free. Il flag -h rende le dimensioni in un

formato facile da usare, cioè GB invece di B. Il flag

type -T mostra che tipo di filesystem è

ogni risorsa.

I filesystem locali (ext, tmp, xfs, zfs) dipendono dal fatto che ci si trovi sullo stesso nodo di accesso (o nodo di calcolo, più avanti). I filesystem in rete (beegfs, cifs, gpfs, nfs, pvfs) saranno simili — ma potrebbero includere yourUsername, a seconda di come viene [montato] (https://en.wikipedia.org/wiki/Mount_(computing)).

Filesystem condivisi

Questo è un punto importante da ricordare: i file salvati su un nodo (computer) sono spesso disponibili ovunque nel cluster!

Confronta il computer, il nodo di accesso e il nodo di calcolo

Confrontate il numero di processori e di memoria del vostro portatile con i numeri che vedete sul nodo principale del cluster e sul nodo worker. Discutete le differenze con il vostro vicino.

Quali implicazioni pensi che possano avere le differenze nell’esecuzione del tuo lavoro di ricerca sui diversi sistemi e nodi?

Differenze tra i nodi

Molti cluster HPC hanno una varietà di nodi ottimizzati per particolari carichi di lavoro. Alcuni nodi possono disporre di una maggiore quantità di memoria o di risorse specializzate come le unità di elaborazione grafica (GPU).

Con tutto questo in mente, ora vedremo come parlare con lo scheduler del cluster e usarlo per iniziare a eseguire i nostri script e programmi!

- “Un sistema HPC è un insieme di macchine collegate in rete”

- “I sistemi HPC forniscono tipicamente nodi di accesso e una serie di nodi lavoratori.”

- “Le risorse presenti sui nodi indipendenti (lavoratori) possono variare in volume e tipo (quantità di RAM, architettura del processore, disponibilità di filesystem montati in rete, ecc.)

- “I file salvati su un nodo sono disponibili su tutti i nodi.”

Content from Fondamenti di scheduler

Ultimo aggiornamento il 2026-01-15 | Modifica questa pagina

Panoramica

Domande

- Cos’è uno scheduler e perché un cluster ne ha bisogno?

- Come si lancia un programma da eseguire su un nodo di calcolo del cluster?

- Come posso catturare l’output di un programma eseguito su un nodo del cluster?

Obiettivi

- Invia un semplice script al cluster.

- Monitorare l’esecuzione dei lavori utilizzando gli strumenti della riga di comando.

- Ispezionare i file di output e di errore dei lavori.

- Trovare il posto giusto per mettere grandi insiemi di dati sul cluster.

Programmatore di lavoro

Un sistema HPC può avere migliaia di nodi e migliaia di utenti. Come si decide chi riceve cosa e quando? Come facciamo a garantire che un task venga eseguito con le risorse di cui ha bisogno? Questo lavoro è gestito da uno speciale software chiamato scheduler. In un sistema HPC, lo scheduler gestisce i lavori da eseguire dove e quando.

L’illustrazione seguente paragona i compiti di uno schedulatore di lavori a quelli di un cameriere in un ristorante. Se vi è capitato di dover aspettare un po’ in coda per entrare in un ristorante famoso, allora potete capire perché a volte i vostri lavori non partono immediatamente come nel vostro portatile.

Lo scheduler utilizzato in questa lezione è Slurm. Sebbene Slurm non sia utilizzato ovunque, l’esecuzione dei lavori è abbastanza simile indipendentemente dal software utilizzato. La sintassi esatta può cambiare, ma i concetti rimangono gli stessi.

Esecuzione di un lavoro batch

L’uso più semplice dello scheduler è quello di eseguire un comando in modo non interattivo. Qualsiasi comando (o serie di comandi) che si desidera eseguire sul cluster è chiamato lavoro e il processo di utilizzo dello schedulatore per eseguire il lavoro è chiamato invio di lavori in batch.

In questo caso, il lavoro da eseguire è uno script di shell, ovvero un file di testo contenente un elenco di comandi UNIX da eseguire in modo sequenziale. Il nostro script di shell sarà composto da tre parti:

- Alla prima riga, aggiungere

#!/bin/bash. L’opzione#!(pronunciata “hash-bang” o “shebang”) indica al computer quale programma deve elaborare il contenuto di questo file. In questo caso, gli stiamo dicendo che i comandi che seguono sono scritti per la shell a riga di comando (con cui abbiamo fatto tutto finora). - in qualsiasi punto sotto la prima riga, aggiungeremo un comando

echocon un saluto amichevole. Una volta eseguito, lo script di shell stamperà nel terminale qualsiasi cosa venga dopoecho.-

echo -nstamperà tutto ciò che segue, senza terminare la riga stampando il carattere di nuova riga.

-

- Nell’ultima riga, invocheremo il comando

hostname, che stamperà il nome della macchina su cui viene eseguito lo script.

Creare il nostro lavoro di prova

Eseguire lo script. Viene eseguito sul cluster o solo sul nostro nodo di accesso?

Questo script è stato eseguito sul nodo di login, ma vogliamo

sfruttare i nodi di calcolo: abbiamo bisogno che lo scheduler metta in

coda example-job.sh per eseguirlo su un nodo di

calcolo.

Per inviare questo task allo scheduler, si usa il comando

sbatch. Questo crea un lavoro che eseguirà il

script quando verrà spedito a un nodo di calcolo che

il sistema di accodamento ha identificato come disponibile per eseguire

il lavoro.

OUTPUT

Submitted batch job 7E questo è tutto ciò che dobbiamo fare per inviare un lavoro. Il

nostro lavoro è finito: ora lo scheduler prende il sopravvento e cerca

di eseguire il lavoro per noi. Mentre il lavoro è in attesa di essere

eseguito, viene inserito in un elenco di lavori chiamato queue.

Per verificare lo stato del nostro lavoro, controlliamo la coda usando

il comando squeue -u yourUsername.

OUTPUT

JOBID PARTITION NAME USER ST TIME NODES NODELIST(REASON)

9 cpubase_b example- user01 R 0:05 1 node1Possiamo vedere tutti i dettagli del nostro lavoro, soprattutto che è

nello stato R o RUNNING. A volte i nostri

lavori potrebbero dover aspettare in coda (PENDING) o avere

un errore (E).

Dov’è l’output?

Nel nodo di accesso, questo script stampava l’output nel terminale,

ma ora, quando squeue mostra che il lavoro è terminato, non

viene stampato nulla nel terminale.

L’output del lavoro del cluster viene solitamente reindirizzato a un

file nella directory da cui è stato lanciato. Usare ls per

trovare e cat per leggere il file.

Personalizzazione di un lavoro

Il lavoro appena eseguito ha utilizzato tutte le opzioni predefinite dello schedulatore. In uno scenario reale, probabilmente non è quello che vogliamo. Le opzioni predefinite rappresentano un minimo ragionevole. È probabile che avremo bisogno di più core, più memoria, più tempo e altre considerazioni speciali. Per avere accesso a queste risorse, dobbiamo personalizzare il nostro script di lavoro.

I commenti negli script di shell UNIX (indicati con #)

sono generalmente ignorati, ma ci sono delle eccezioni. Per esempio, il

commento speciale #! all’inizio degli script specifica

quale programma deve essere usato per eseguirli (di solito si vede

#!/usr/bin/env bash). Anche gli schedulatori, come Slurm,

hanno un commento speciale usato per indicare opzioni specifiche dello

schedulatore. Sebbene questi commenti differiscano da schedulatore a

schedulatore, il commento speciale di Slurm è #SBATCH.

Tutto ciò che segue il commento #SBATCH viene interpretato

come un’istruzione per lo schedulatore.

Illustriamo questo esempio. Per impostazione predefinita, il nome di

un lavoro è il nome dello script, ma l’opzione -J può

essere usata per cambiare il nome di un lavoro. Aggiungere un’opzione

allo script:

Inviare il lavoro e monitorarne lo stato:

OUTPUT

JOBID PARTITION NAME USER ST TIME NODES NODELIST(REASON)

10 cpubase_b hello-wo user01 R 0:02 1 node1Fantastico, abbiamo cambiato con successo il nome del nostro lavoro!

Richieste di risorse

Che dire di cambiamenti più importanti, come il numero di core e di memoria per i nostri lavori? Una cosa assolutamente fondamentale quando si lavora su un sistema HPC è specificare le risorse necessarie per eseguire un lavoro. Questo permette allo scheduler di trovare il momento e il posto giusto per programmare il nostro lavoro. Se non si specificano i requisiti (ad esempio la quantità di tempo necessaria), è probabile che si rimanga bloccati con le risorse predefinite del sito, il che probabilmente non è ciò che si desidera.

Le seguenti sono diverse richieste di risorse chiave:

--ntasks=<ntasks>o-n <ntasks>: Di quanti core di CPU ha bisogno il vostro lavoro, in totale?--time <days-hours:minutes:seconds>o-t <days-hours:minutes:seconds>: Quanto tempo reale (walltime) impiegherà il lavoro per essere eseguito? La parte<days>può essere omessa.--mem=<megabytes>: Di quanta memoria su un nodo ha bisogno il lavoro in megabyte? Si possono anche specificare i gigabyte aggiungendo una piccola “g” dopo (esempio:--mem=5g)--nodes=<nnodes>o-N <nnodes>: Su quante macchine separate deve essere eseguito il lavoro? Si noti che se si impostantaskssu un numero superiore a quello che può offrire una sola macchina, Slurm imposterà automaticamente questo valore.

Si noti che il solo fatto di richiedere queste risorse non rende il lavoro più veloce, né significa necessariamente che si consumeranno tutte queste risorse. Significa solo che vengono messe a disposizione. Il lavoro può finire per utilizzare meno memoria, meno tempo o meno nodi di quelli richiesti, ma verrà comunque eseguito.

È meglio che le richieste riflettano accuratamente i requisiti del lavoro. In una puntata successiva di questa lezione parleremo di come assicurarsi di utilizzare le risorse in modo efficace.

Invio di richieste di risorse

Modificare il nostro script hostname in modo che venga

eseguito per un minuto, quindi inviare un lavoro per esso sul

cluster.

Le richieste di risorse sono in genere vincolanti. Se si superano, il lavoro viene eliminato. Utilizziamo il tempo di parete come esempio. Richiederemo 1 minuto di tempo di parete e cercheremo di eseguire un lavoro per due minuti.

BASH

#!/bin/bash

#SBATCH -J long_job

#SBATCH -t 00:01 # timeout in HH:MM

echo "This script is running on ... "

sleep 240 # time in seconds

hostnameInviare il lavoro e attendere che finisca. Una volta terminato, controllare il file di log.

OUTPUT

This script is running on ...

slurmstepd: error: *** JOB 12 ON node1 CANCELLED AT 2021-02-19T13:55:57

DUE TO TIME LIMIT ***Il nostro lavoro è stato annullato per aver superato la quantità di risorse richieste. Anche se questo sembra un problema, in realtà si tratta di una caratteristica. Il rispetto rigoroso delle richieste di risorse consente allo scheduler di trovare il miglior posto possibile per i lavori. Ancora più importante, garantisce che un altro utente non possa utilizzare più risorse di quelle che gli sono state assegnate. Se un altro utente sbaglia e tenta accidentalmente di usare tutti i core o la memoria di un nodo, Slurm limiterà il suo lavoro alle risorse richieste o lo ucciderà del tutto. Gli altri lavori sul nodo non ne risentiranno. Ciò significa che un utente non può rovinare l’esperienza degli altri: gli unici lavori interessati da un errore di programmazione saranno i propri.

Annullamento di un lavoro

A volte capita di commettere un errore e di dover cancellare un

lavoro. Questo può essere fatto con il comando scancel.

Inviamo un lavoro e poi annulliamolo usando il suo numero di lavoro

(ricordate di cambiare il tempo di esecuzione in modo che funzioni

abbastanza a lungo da permettervi di annullarlo prima che venga

ucciso).

OUTPUT

Submitted batch job 13

JOBID PARTITION NAME USER ST TIME NODES NODELIST(REASON)

13 cpubase_b long_job user01 R 0:02 1 node1Ora annullate il lavoro con il suo numero (stampato nel terminale). Un ritorno pulito del prompt dei comandi indica che la richiesta di annullamento del lavoro è andata a buon fine.

BASH

[yourUsername@login1 ~] scancel 38759

# It might take a minute for the job to disappear from the queue...

[yourUsername@login1 ~] squeue -u yourUsernameOUTPUT

JOBID PARTITION NAME USER ST TIME NODES NODELIST(REASON)Annullamento di lavori multipli

È anche possibile cancellare tutti i lavori in una volta sola usando

l’opzione -u. In questo modo si cancellano tutti i lavori

di un utente specifico (in questo caso, l’utente stesso). Si noti che è

possibile cancellare solo i propri lavori.

Provare a inviare più lavori e poi annullarli tutti.

Altri tipi di lavoro

Finora ci siamo concentrati sull’esecuzione di lavori in modalità

batch. Slurm offre anche la possibilità di avviare una

sessione interattiva.

Molto spesso ci sono compiti che devono essere eseguiti in modo

interattivo. Creare un intero script di lavoro potrebbe essere

eccessivo, ma la quantità di risorse richieste è troppo elevata per

essere gestita da un nodo di login. Un buon esempio potrebbe essere la

creazione di un indice del genoma per l’allineamento con uno strumento

come HISAT2.

Fortunatamente, è possibile eseguire questo tipo di compiti una tantum

con srun.

srun esegue un singolo comando sul cluster e poi esce.

Dimostriamo questo eseguendo il comando hostname con

srun. (È possibile annullare un lavoro srun

con Ctrl-c)

OUTPUT

smnode1srun accetta tutte le stesse opzioni di

sbatch. Tuttavia, invece di specificarle in uno script,

queste opzioni vengono specificate sulla riga di comando quando si avvia

un lavoro. Per inviare un lavoro che utilizza 2 CPU, ad esempio, si può

usare il seguente comando:

OUTPUT

This job will use 2 CPUs.

This job will use 2 CPUs.In genere, l’ambiente di shell risultante sarà lo stesso di quello di

sbatch.

Lavori interattivi

A volte si ha bisogno di molte risorse per l’uso interattivo. Forse è

la prima volta che si esegue un’analisi o si sta cercando di eseguire il

debug di qualcosa che è andato storto con un lavoro precedente.

Fortunatamente, Slurm semplifica l’avvio di un lavoro interattivo con

srun:

Dovrebbe apparire un prompt di bash. Si noti che il prompt

probabilmente cambierà per riflettere la nuova posizione, in questo caso

il nodo di calcolo su cui si è effettuato l’accesso. Si può anche

verificare con hostname.

Creazione della grafica remota

Per vedere l’output grafico dei lavori, è necessario utilizzare

l’inoltro X11. Per connettersi con questa funzione abilitata, usare

l’opzione -Y quando si effettua il login con il comando

ssh, ad esempio,

ssh -Y yourUsername@cluster.hpc-carpentry.org.

Per dimostrare cosa succede quando si crea una finestra grafica sul

nodo remoto, usare il comando xeyes. Dovrebbe apparire un

paio di occhi relativamente adorabili (premere Ctrl-C per

fermarsi). Se si utilizza un Mac, è necessario aver installato XQuartz

(e riavviato il computer) perché questo funzioni.

Se nel cluster è installato il plugin slurm-spank-x11,

si può garantire l’inoltro X11 nei lavori interattivi usando l’opzione

--x11 per srun con il comando

srun --x11 --pty bash.

Al termine del lavoro interattivo, digitare exit per

uscire dalla sessione.

- Lo scheduler gestisce la condivisione delle risorse di calcolo tra gli utenti.

- Un lavoro è solo uno script di shell.

- Richiedere poco più risorse di quelle necessarie.

Content from Variabili d'ambiente

Ultimo aggiornamento il 2026-01-15 | Modifica questa pagina

Panoramica

Domande

- Come si impostano e come si accede alle variabili nella shell Unix?

- Come si possono usare le variabili per cambiare l’esecuzione di un programma?

Obiettivi

- Capire come vengono implementate le variabili nella shell

- Scoprire il valore di una variabile esistente

- Creare nuove variabili e cambiarne i valori

- Modificare il comportamento di un programma utilizzando una variabile d’ambiente

- Spiegare come la shell utilizza la variabile

PATHper cercare gli eseguibili

Provenienza dell’episodio

Questo episodio è derivato dall’episodio Shell Extras sulle variabili di shell e dall’episodio HPC Shell sugli script.

La shell è solo un programma e, come gli altri programmi, ha delle variabili. Queste variabili controllano la sua esecuzione, quindi cambiando i loro valori si può cambiare il comportamento della shell (e, con un po’ più di sforzo, il comportamento degli altri programmi).

Le variabili sono un ottimo modo per salvare informazioni con un nome a cui si può accedere in seguito. Nei linguaggi di programmazione come Python e R, le variabili possono memorizzare praticamente tutto ciò che si può pensare. Nella shell, di solito, memorizzano solo testo. Il modo migliore per capire come funzionano è vederle in azione.

Cominciamo con l’eseguire il comando set e osserviamo

alcune delle variabili in una tipica sessione di shell:

OUTPUT

COMPUTERNAME=TURING

HOME=/home/vlad

HOSTNAME=TURING

HOSTTYPE=i686

NUMBER_OF_PROCESSORS=4

PATH=/Users/vlad/bin:/usr/local/git/bin:/usr/bin:/bin:/usr/sbin:/sbin:/usr/local/bin

PWD=/home/vlad

UID=1000

USERNAME=vlad

...Come si può vedere, ce ne sono parecchie, anzi quattro o cinque volte

di più di quelle mostrate qui. E sì, l’uso di set per

mostrare le cose può sembrare un po’ strano, anche per Unix, ma

se non gli si dà alcun argomento, può anche mostrare cose che si possono

impostare.

Ogni variabile ha un nome. Tutti i valori delle variabili di shell

sono stringhe, anche quelle (come UID) che sembrano numeri.

Spetta ai programmi convertire queste stringhe in altri tipi, se

necessario. Per esempio, se un programma volesse sapere quanti

processori ha il computer, convertirebbe il valore della variabile

NUMBER_OF_PROCESSORS da una stringa a un numero intero.

Mostrare il valore di una variabile

Mostriamo il valore della variabile HOME:

OUTPUT

HOMEQuesto stampa solo “HOME”, che non è quello che volevamo (anche se è quello che abbiamo effettivamente chiesto). Proviamo invece questo:

OUTPUT

/home/vladdove il segno del dollaro indica alla shell che vogliamo il

valore della variabile piuttosto che il suo nome. Questo

funziona proprio come i caratteri jolly: la shell effettua la

sostituzione prima di eseguire il programma richiesto. Grazie a

questa espansione, ciò che viene eseguito è

echo /home/vlad, che mostra la risposta che stavamo

cercando.

Creazione e modifica di variabili

Creare una variabile è facile: basta assegnare un valore a un nome

usando “=” (bisogna solo ricordare che la sintassi richiede che non ci

siano spazi intorno a =):

OUTPUT

DraculaPer cambiare il valore, basta assegnarne uno nuovo:

OUTPUT

CamillaVariabili d’ambiente

Quando abbiamo eseguito il comando set abbiamo visto che

c’erano molte variabili i cui nomi erano in maiuscolo. Questo perché,

per convenzione, le variabili che sono disponibili per l’uso da parte di

altri programmi hanno nomi maiuscoli. Tali variabili sono

chiamate variabili d’ambiente in quanto sono variabili di shell

definite per la shell corrente ed ereditate da qualsiasi shell o altro

processo.

Per creare una variabile d’ambiente è necessario export

una variabile di shell. Ad esempio, per rendere la nostra

SECRET_IDENTITY disponibile ad altri programmi che

chiamiamo dalla nostra shell, possiamo fare:

È anche possibile creare ed esportare la variabile in un unico passaggio:

Usare le variabili d’ambiente per cambiare il comportamento del programma

Impostare una variabile di shell TIME_STYLE per avere un

valore di iso e controllare questo valore con il comando

echo.

Ora, eseguite il comando ls con l’opzione

-l (che dà un formato lungo).

export la variabile e rieseguire il comando

ls -l. Notate qualche differenza?

La variabile TIME_STYLE non viene vista da

ls fino a quando non viene esportata, a quel punto viene

usata da ls per decidere quale formato di data usare quando

presenta il timestamp dei file.

È possibile vedere l’insieme completo delle variabili d’ambiente

nella sessione corrente della shell con il comando env (che

restituisce un sottoinsieme di ciò che ci ha dato il comando

set). L’insieme completo delle variabili d’ambiente

è chiamato ambiente di esecuzione e può influenzare il

comportamento dei programmi eseguiti.

Variabili d’ambiente di lavoro

Quando Slurm esegue un lavoro, imposta una serie di

variabili d’ambiente per il lavoro. Una di queste ci permette di

verificare da quale cartella è stato inviato lo script del lavoro. La

variabile SLURM_SUBMIT_DIR è impostata sulla cartella da

cui è stato inviato il lavoro. Utilizzando la variabile

SLURM_SUBMIT_DIR, modificate il vostro lavoro in modo che

stampi la posizione da cui è stato inviato il lavoro.

Per rimuovere una variabile o una variabile d’ambiente si può usare

il comando unset, ad esempio:

La variabile d’ambiente PATH

Analogamente, alcune variabili d’ambiente (come PATH)

memorizzano elenchi di valori. In questo caso, la convenzione è di usare

i due punti ‘:’ come separatore. Se un programma vuole i singoli

elementi di un tale elenco, è sua responsabilità dividere il valore

della stringa della variabile in pezzi.

Diamo un’occhiata più da vicino alla variabile PATH. Il

suo valore definisce il percorso di ricerca degli eseguibili della

shell, cioè l’elenco delle cartelle in cui la shell cerca i programmi

eseguibili quando si digita il nome di un programma senza specificare la

cartella in cui si trova.

Ad esempio, quando si digita un comando come analyze, la

shell deve decidere se eseguire ./analyze o

/bin/analyze. La regola che utilizza è semplice: la shell

controlla ogni cartella della variabile PATH a turno,

cercando un programma con il nome richiesto in quella cartella. Non

appena trova una corrispondenza, interrompe la ricerca ed esegue il

programma.

Per mostrare come funziona, ecco i componenti di PATH

elencati uno per riga:

OUTPUT

/Users/vlad/bin

/usr/local/git/bin

/usr/bin

/bin

/usr/sbin

/sbin

/usr/local/binSul nostro computer, ci sono in realtà tre programmi chiamati

analyze in tre diverse directory:

/bin/analyze, /usr/local/bin/analyze e

/users/vlad/analyze. Poiché la shell cerca le cartella

nell’ordine in cui sono elencate in PATH, trova prima

/bin/analyze e lo esegue. Si noti che non troverà mai il

programma /users/vlad/analyze a meno che non si digiti il

percorso completo del programma, poiché la cartella

/users/vlad non si trova in PATH.

Questo significa che posso avere eseguibili in molti posti diversi,

purché mi ricordi che devo aggiornare il mio PATH in modo

che la mia shell possa trovarli.

Cosa succede se si vogliono eseguire due versioni diverse dello

stesso programma? Dato che condividono lo stesso nome, se le aggiungo

entrambe alla mia PATH la prima che viene trovata avrà

sempre la meglio. Nel prossimo episodio impareremo a usare strumenti di

aiuto per gestire il nostro ambiente di runtime, in modo da renderlo

possibile senza dover fare un sacco di conti su quale sia o debba essere

il valore di PATH (e di altre importanti variabili

d’ambiente).

- Le variabili di shell sono trattate per impostazione predefinita come stringhe

- Le variabili vengono assegnate utilizzando “

=” e richiamate utilizzando il nome della variabile preceduto da “$” - Usare “

export” per rendere una variabile disponibile ad altri programmi - La variabile

PATHdefinisce il percorso di ricerca della shell

Content from Accesso al software tramite moduli

Ultimo aggiornamento il 2026-01-15 | Modifica questa pagina

Panoramica

Domande

- Come si caricano e scaricano i pacchetti software?

Obiettivi

- Caricare ed utilizza un pacchetto software.

- Spiegare come cambia l’ambiente della shell quando il meccanismo dei moduli carica o scarica i pacchetti.

In un sistema di calcolo ad alte prestazioni, raramente il software che vogliamo usare è disponibile al momento dell’accesso. È installato, ma è necessario “caricarlo” prima che possa essere eseguito.

Prima di iniziare a utilizzare i singoli pacchetti software, tuttavia, è necessario comprendere il ragionamento alla base di questo approccio. I tre fattori principali sono:

- incompatibilità software

- versioning

- dipendenze

L’incompatibilità del software è un grosso grattacapo per i

programmatori. A volte, la presenza (o l’assenza) di un pacchetto

software ne interrompe altri che dipendono da esso. Due esempi ben noti

sono le versioni dei compilatori Python e C. Python 3 fornisce un

comando python che è in conflitto con quello fornito da

Python 2. Il software compilato con una versione più recente del

compilatore C non è in grado di funzionare. Il software compilato con

una versione più recente delle librerie C e poi eseguito su una macchina

in cui sono installate librerie C più vecchie, darà luogo a uno

spiacevole errore 'GLIBCXX_3.4.20' not found.

La gestione delle versioni del software è un altro problema comune. Un gruppo di lavoro potrebbe dipendere da una certa versione di un pacchetto per il proprio progetto di ricerca; se la versione del software dovesse cambiare (per esempio, se un pacchetto venisse aggiornato), i risultati potrebbero risentirne. Avere accesso a più versioni del software permette a un gruppo di ricercatori di evitare che i problemi di versione del software influenzino i loro risultati.

Le dipendenze si riferiscono a quando un particolare pacchetto software (o anche una particolare versione) dipende dall’accesso a un altro pacchetto software (o anche a una particolare versione di un altro pacchetto software). Ad esempio, il software per la scienza dei materiali VASP può dipendere dalla disponibilità di una particolare versione della libreria software FFTW (Fastest Fourier Transform in the West) per funzionare.

Moduli d’ambiente

I moduli d’ambiente sono la soluzione a questi problemi. Un modulo è una descrizione autonoma di un pacchetto software: contiene le impostazioni necessarie per eseguire un pacchetto software e, di solito, codifica le dipendenze necessarie da altri pacchetti software.

Esistono diverse implementazioni di moduli di ambiente comunemente

utilizzate sui sistemi HPC: le due più comuni sono TCL modules

e Lmod. Entrambi utilizzano una sintassi simile e i concetti

sono gli stessi, quindi imparare a usarne uno vi permetterà di

utilizzare quello installato sul sistema che state usando. In entrambe

le implementazioni il comando module è usato per interagire

con i moduli di ambiente. Al comando viene solitamente aggiunto un

ulteriore sottocomando per specificare ciò che si vuole fare. Per un

elenco di sottocomandi si può usare module -h o

module help. Come per tutti i comandi, è possibile accedere

alla guida completa nelle pagine di man con

man module.

All’accesso si può iniziare con un set predefinito di moduli caricati o con un ambiente vuoto; ciò dipende dalla configurazione del sistema in uso.

Elenco dei moduli disponibili

Per vedere i moduli software disponibili, usare

module avail:

OUTPUT

~~~ /cvmfs/pilot.eessi-hpc.org/2020.12/software/x86_64/amd/zen2/modules/all ~~~

Bazel/3.6.0-GCCcore-x.y.z NSS/3.51-GCCcore-x.y.z

Bison/3.5.3-GCCcore-x.y.z Ninja/1.10.0-GCCcore-x.y.z

Boost/1.72.0-gompi-2020a OSU-Micro-Benchmarks/5.6.3-gompi-2020a

CGAL/4.14.3-gompi-2020a-Python-3.x.y OpenBLAS/0.3.9-GCC-x.y.z

CMake/3.16.4-GCCcore-x.y.z OpenFOAM/v2006-foss-2020a

[removed most of the output here for clarity]

Where:

L: Module is loaded

Aliases: Aliases exist: foo/1.2.3 (1.2) means that "module load foo/1.2"

will load foo/1.2.3

D: Default Module

Use "module spider" to find all possible modules and extensions.

Use "module keyword key1 key2 ..." to search for all possible modules matching

any of the "keys".Caricamento e scaricamento del software

Per caricare un modulo software, usare module load. In

questo esempio useremo Python 3.

Inizialmente, Python 3 non viene caricato. Si può verificare usando

il comando which che cerca i programmi nello stesso modo in

cui lo fa Bash, quindi possiamo usarlo per sapere dove è memorizzato un

particolare software.

Se il comando python3 non fosse disponibile, si vedrebbe

un risultato come

OUTPUT

/usr/bin/which: no python3 in (/cvmfs/pilot.eessi-hpc.org/2020.12/compat/linux/x86_64/usr/bin:/opt/software/slurm/bin:/usr/local/bin:/usr/bin:/usr/local/sbin:/usr/sbin:/opt/puppetlabs/bin:/home/yourUsername/.local/bin:/home/yourUsername/bin)Si noti che questo blocco di testo è in realtà un elenco, con i

valori separati dal carattere :. L’output ci dice che il

comando which ha cercato python3 nelle

seguenti directory, senza successo:

OUTPUT

/cvmfs/pilot.eessi-hpc.org/2020.12/compat/linux/x86_64/usr/bin

/opt/software/slurm/bin

/usr/local/bin

/usr/bin

/usr/local/sbin

/usr/sbin

/opt/puppetlabs/bin

/home/yourUsername/.local/bin

/home/yourUsername/binTuttavia, nel nostro caso abbiamo un python3 esistente

disponibile, quindi vediamo

OUTPUT

/cvmfs/pilot.eessi-hpc.org/2020.12/compat/linux/x86_64/usr/bin/python3Comunque abbiamo bisogno di un Python diverso da quello fornito dal sistema, quindi carichiamo un modulo per accedervi.

Possiamo caricare il comando python3 con

module load:

OUTPUT

/cvmfs/pilot.eessi-hpc.org/2020.12/software/x86_64/amd/zen2/software/Python/3.x.y-GCCcore-x.y.z/bin/python3Allora, cosa è successo?

Per comprendere l’output, occorre innanzitutto capire la natura della

variabile d’ambiente $PATH. $PATH è una

variabile d’ambiente speciale che controlla dove un sistema UNIX cerca

il software. In particolare, $PATH è un elenco di directory

(separate da :) in cui il sistema operativo cerca un

comando prima di arrendersi e dire che non lo trova. Come per tutte le

variabili d’ambiente, è possibile stamparle usando

echo.

OUTPUT

/cvmfs/pilot.eessi-hpc.org/2020.12/software/x86_64/amd/zen2/software/Python/3.x.y-GCCcore-x.y.z/bin:/cvmfs/pilot.eessi-hpc.org/2020.12/software/x86_64/amd/zen2/software/SQLite/3.31.1-GCCcore-x.y.z/bin:/cvmfs/pilot.eessi-hpc.org/2020.12/software/x86_64/amd/zen2/software/Tcl/8.6.10-GCCcore-x.y.z/bin:/cvmfs/pilot.eessi-hpc.org/2020.12/software/x86_64/amd/zen2/software/GCCcore/x.y.z/bin:/cvmfs/pilot.eessi-hpc.org/2020.12/compat/linux/x86_64/usr/bin:/opt/software/slurm/bin:/usr/local/bin:/usr/bin:/usr/local/sbin:/usr/sbin:/opt/puppetlabs/bin:/home/user01/.local/bin:/home/user01/binNoterete una somiglianza con l’output del comando which.

In questo caso, c’è solo una differenza: la diversa cartella all’inizio.

Quando abbiamo eseguito il comando module load, questo ha

aggiunto una cartella all’inizio del nostro $PATH.

Esaminiamo cosa c’è:

BASH

[yourUsername@login1 ~] ls /cvmfs/pilot.eessi-hpc.org/2020.12/software/x86_64/amd/zen2/software/Python/3.x.y-GCCcore-x.y.z/binOUTPUT

2to3 nosetests-3.8 python rst2s5.py

2to3-3.8 pasteurize python3 rst2xetex.py

chardetect pbr python3.8 rst2xml.py

cygdb pip python3.8-config rstpep2html.py

cython pip3 python3-config runxlrd.py

cythonize pip3.8 rst2html4.py sphinx-apidoc

easy_install pybabel rst2html5.py sphinx-autogen

easy_install-3.8 __pycache__ rst2html.py sphinx-build

futurize pydoc3 rst2latex.py sphinx-quickstart

idle3 pydoc3.8 rst2man.py tabulate

idle3.8 pygmentize rst2odt_prepstyles.py virtualenv

netaddr pytest rst2odt.py wheel

nosetests py.test rst2pseudoxml.pyPortando questo alla sua conclusione, module load

aggiungerà software al vostro $PATH e carica il software.

Una nota speciale: a seconda della versione del programma

module installata nel sito, module load

caricherà anche le dipendenze software necessarie.

Per dimostrarlo, usiamo module list che mostra tutti i

moduli software caricati.

OUTPUT

Currently Loaded Modules:

1) GCCcore/x.y.z 4) GMP/6.2.0-GCCcore-x.y.z

2) Tcl/8.6.10-GCCcore-x.y.z 5) libffi/3.3-GCCcore-x.y.z

3) SQLite/3.31.1-GCCcore-x.y.z 6) Python/3.x.y-GCCcore-x.y.zOUTPUT

Currently Loaded Modules:

1) GCCcore/x.y.z 14) libfabric/1.11.0-GCCcore-x.y.z

2) Tcl/8.6.10-GCCcore-x.y.z 15) PMIx/3.1.5-GCCcore-x.y.z

3) SQLite/3.31.1-GCCcore-x.y.z 16) OpenMPI/4.0.3-GCC-x.y.z

4) GMP/6.2.0-GCCcore-x.y.z 17) OpenBLAS/0.3.9-GCC-x.y.z

5) libffi/3.3-GCCcore-x.y.z 18) gompi/2020a

6) Python/3.x.y-GCCcore-x.y.z 19) FFTW/3.3.8-gompi-2020a

7) GCC/x.y.z 20) ScaLAPACK/2.1.0-gompi-2020a

8) numactl/2.0.13-GCCcore-x.y.z 21) foss/2020a

9) libxml2/2.9.10-GCCcore-x.y.z 22) pybind11/2.4.3-GCCcore-x.y.z-Pytho...

10) libpciaccess/0.16-GCCcore-x.y.z 23) SciPy-bundle/2020.03-foss-2020a-Py...

11) hwloc/2.2.0-GCCcore-x.y.z 24) networkx/2.4-foss-2020a-Python-3.8...

12) libevent/2.1.11-GCCcore-x.y.z 25) GROMACS/2020.1-foss-2020a-Python-3...

13) UCX/1.8.0-GCCcore-x.y.zIn questo caso, il caricamento del modulo GROMACS (un

pacchetto software bioinformatico) ha caricato anche

GMP/6.2.0-GCCcore-x.y.z e

SciPy-bundle/2020.03-foss-2020a-Python-3.x.y. Proviamo a

scaricare il pacchetto GROMACS.

OUTPUT

Currently Loaded Modules:

1) GCCcore/x.y.z 13) UCX/1.8.0-GCCcore-x.y.z

2) Tcl/8.6.10-GCCcore-x.y.z 14) libfabric/1.11.0-GCCcore-x.y.z

3) SQLite/3.31.1-GCCcore-x.y.z 15) PMIx/3.1.5-GCCcore-x.y.z

4) GMP/6.2.0-GCCcore-x.y.z 16) OpenMPI/4.0.3-GCC-x.y.z

5) libffi/3.3-GCCcore-x.y.z 17) OpenBLAS/0.3.9-GCC-x.y.z

6) Python/3.x.y-GCCcore-x.y.z 18) gompi/2020a

7) GCC/x.y.z 19) FFTW/3.3.8-gompi-2020a

8) numactl/2.0.13-GCCcore-x.y.z 20) ScaLAPACK/2.1.0-gompi-2020a

9) libxml2/2.9.10-GCCcore-x.y.z 21) foss/2020a

10) libpciaccess/0.16-GCCcore-x.y.z 22) pybind11/2.4.3-GCCcore-x.y.z-Pytho...

11) hwloc/2.2.0-GCCcore-x.y.z 23) SciPy-bundle/2020.03-foss-2020a-Py...

12) libevent/2.1.11-GCCcore-x.y.z 24) networkx/2.4-foss-2020a-Python-3.x.yL’uso di module unload “scarica” un modulo e, a seconda

di come è configurato un sito, può anche scaricare tutte le dipendenze

(nel nostro caso non lo fa). Se si volesse scaricare tutto in una volta,

si potrebbe eseguire module purge (scarica tutto).

OUTPUT

No modules loadedSi noti che module purge è informativo perché ci farà

anche sapere se un insieme predefinito di pacchetti “appiccicosi” non

può essere scaricato (e come scaricarli se lo si desidera

veramente).

Questo processo di caricamento del modulo avviene principalmente

attraverso la manipolazione di variabili d’ambiente come

$PATH. Di solito il trasferimento di dati è minimo o

nullo.

Il processo di caricamento dei moduli manipola anche altre variabili d’ambiente speciali, tra cui quelle che influenzano la ricerca delle librerie software da parte del sistema e, talvolta, quelle che indicano ai pacchetti software commerciali dove trovare i server delle licenze.

Il comando module ripristina anche queste variabili d’ambiente della shell al loro stato precedente quando un modulo viene scaricato.

Versione del software

Finora abbiamo imparato a caricare e scaricare i pacchetti software. Questo è molto utile. Tuttavia, non abbiamo ancora affrontato il problema del versionamento del software. Prima o poi ci si imbatterà in problemi in cui solo una particolare versione di un software sarà adatta. Forse la correzione di un bug fondamentale è avvenuta solo in una certa versione, oppure la versione X ha interrotto la compatibilità con un formato di file utilizzato. In entrambi questi casi, è utile essere molto precisi sul software caricato.

Esaminiamo più da vicino l’output di module avail.

OUTPUT

~~~ /cvmfs/pilot.eessi-hpc.org/2020.12/software/x86_64/amd/zen2/modules/all ~~~

Bazel/3.6.0-GCCcore-x.y.z NSS/3.51-GCCcore-x.y.z

Bison/3.5.3-GCCcore-x.y.z Ninja/1.10.0-GCCcore-x.y.z

Boost/1.72.0-gompi-2020a OSU-Micro-Benchmarks/5.6.3-gompi-2020a

CGAL/4.14.3-gompi-2020a-Python-3.x.y OpenBLAS/0.3.9-GCC-x.y.z

CMake/3.16.4-GCCcore-x.y.z OpenFOAM/v2006-foss-2020a

[removed most of the output here for clarity]

Where:

L: Module is loaded

Aliases: Aliases exist: foo/1.2.3 (1.2) means that "module load foo/1.2"

will load foo/1.2.3

D: Default Module

Use "module spider" to find all possible modules and extensions.

Use "module keyword key1 key2 ..." to search for all possible modules matching

any of the "keys".Utilizzo dei moduli software negli script

Creare un lavoro in grado di eseguire python3 --version.

Ricordate che per impostazione predefinita non viene caricato alcun

software! Eseguire un lavoro è come accedere al sistema (non si deve

dare per scontato che un modulo caricato sul nodo di login sia caricato

su un nodo di calcolo).

- Caricare il software con

module load softwareName. - Scaricare il software con

module unload - Il sistema dei moduli gestisce automaticamente le versioni del software e i conflitti tra i pacchetti.

Content from Trasferimento di file da computer remoti

Ultimo aggiornamento il 2026-01-15 | Modifica questa pagina

Panoramica

Domande

- Come si trasferiscono i file al (e dal) cluster?

Obiettivi

- Trasferimento di file da e verso un cluster di calcolo.

Eseguire il lavoro su un computer remoto non è molto utile se non si possono muovere file da o verso il cluster. Esistono diverse opzioni per trasferire i dati tra le risorse di calcolo utilizzando le utility CLI e GUI. Qui di seguito tratteremo alcune di queste opzioni.

Scaricare i file delle lezioni da Internet

Uno dei modi più semplici per scaricare i file è usare

curl o wget. Almeno uno di questi è

solitamente installato nella maggior parte delle shell di Linux, nel

terminale di Mac OS e in GitBash. Qualsiasi file che può essere

scaricato nel browser web attraverso un link diretto può essere

scaricato usando curl o wget. Si tratta di un

modo rapido per scaricare insiemi di dati o codice sorgente. La sintassi

di questi comandi è

wget [-O new_name] https://some/link/to/a/filecurl [-o new_name] https://some/link/to/a/file

provate a scaricare del materiale che useremo in seguito, da un terminale sulla vostra macchina locale, usando l’URL della base di codice corrente:

https://github.com/hpc-carpentry/amdahl/tarball/main

Scarica il “Tarball”

La parola “tarball” nell’URL di cui sopra si riferisce a un formato

di archivio compresso comunemente usato su Linux, che è il sistema

operativo su cui gira la maggior parte dei cluster HPC. Un tarball è

molto simile a un file .zip. L’estensione effettiva del

file è .tar.gz, che riflette il processo in due fasi

utilizzato per creare il file: i file o le cartelle vengono uniti in un

unico file utilizzando tar, che viene poi compresso

utilizzando gzip, quindi l’estensione del file è

“tar-dot-g-z” È una parola lunga, quindi spesso si dice “il tarball

xyz”.

si può anche vedere l’estensione .tgz, che è solo

un’abbreviazione di .tar.gz.

Per impostazione predefinita, curl e wget

scaricano i file con lo stesso nome dell’URL: in questo caso,

main. Usare uno dei comandi precedenti per salvare il

tarball come amdahl.tar.gz.

Dopo aver scaricato il file, si può usare ls per vederlo

nella propria cartella di lavoro:

Archiviazione dei file

Una delle maggiori sfide che spesso ci troviamo ad affrontare quando trasferiamo dati tra sistemi HPC remoti è quella di un gran numero di file. Il trasferimento di ogni singolo file comporta un sovraccarico e quando si trasferisce un gran numero di file questi sovraccarichi si combinano per rallentare notevolmente i trasferimenti.

La soluzione a questo problema è quella di archiviare più

file in un numero minore di file più grandi prima di trasferire i dati

per migliorare l’efficienza del trasferimento. A volte si combina

l’archiviazione con la compressione per ridurre la quantità di

dati da trasferire e quindi velocizzare il trasferimento. Il comando di

archiviazione più comune che si usa su un cluster HPC (Linux) è

tar.

tar può essere usato per combinare file e cartelle in un

unico file di archivio e, facoltativamente, comprimere il risultato.

Osserviamo il file scaricato dal sito della lezione,

amdahl.tar.gz.

La parte .gz sta per gzip, che è una libreria

di compressione. È comune (ma non necessario!) che questo tipo di file

possa essere interpretato leggendo il suo nome: sembra che qualcuno

abbia preso file e cartelle relativi a qualcosa chiamato “amdahl”, li

abbia impacchettati tutti in un singolo file con tar,

quindi abbia compresso l’archivio con gzip per risparmiare

spazio.

Vediamo se questo è il caso, senza scompattare il file.

tar stampa il “**testo del contenuto” con il flag

-t, per il file specificato con il flag -f

seguito dal nome del file. Si noti che è possibile concatenare i due

flag: scrivere -t -f è intercambiabile con scrivere

-tf insieme. Tuttavia, l’argomento che segue

-f deve essere un nome di file, quindi scrivere

-ft non funzionerà.

BASH

[you@laptop:~]$ tar -tf amdahl.tar.gz

hpc-carpentry-amdahl-46c9b4b/

hpc-carpentry-amdahl-46c9b4b/.github/

hpc-carpentry-amdahl-46c9b4b/.github/workflows/

hpc-carpentry-amdahl-46c9b4b/.github/workflows/python-publish.yml

hpc-carpentry-amdahl-46c9b4b/.gitignore

hpc-carpentry-amdahl-46c9b4b/LICENSE

hpc-carpentry-amdahl-46c9b4b/README.md

hpc-carpentry-amdahl-46c9b4b/amdahl/

hpc-carpentry-amdahl-46c9b4b/amdahl/__init__.py

hpc-carpentry-amdahl-46c9b4b/amdahl/__main__.py

hpc-carpentry-amdahl-46c9b4b/amdahl/amdahl.py

hpc-carpentry-amdahl-46c9b4b/requirements.txt

hpc-carpentry-amdahl-46c9b4b/setup.pyQuesto esempio di output mostra una cartella che contiene alcuni

file, dove 46c9b4b è un hash di commit di 8 caratteri git che cambierà

quando il materiale sorgente verrà aggiornato.

Ora scompattiamo l’archivio. Eseguiremo tar con alcuni

flag comuni:

-

-xper estrarre l’archivio -

-vper un output verboso -

-zper la compressione gzip -

-f «tarball»per il file da scompattare

Estrazione dell’archivio

Usando i flag di cui sopra, scompattare il tarball del codice

sorgente in una nuova directory chiamata “amdahl” usando

tar.

OUTPUT

hpc-carpentry-amdahl-46c9b4b/

hpc-carpentry-amdahl-46c9b4b/.github/

hpc-carpentry-amdahl-46c9b4b/.github/workflows/

hpc-carpentry-amdahl-46c9b4b/.github/workflows/python-publish.yml

hpc-carpentry-amdahl-46c9b4b/.gitignore

hpc-carpentry-amdahl-46c9b4b/LICENSE

hpc-carpentry-amdahl-46c9b4b/README.md

hpc-carpentry-amdahl-46c9b4b/amdahl/

hpc-carpentry-amdahl-46c9b4b/amdahl/__init__.py

hpc-carpentry-amdahl-46c9b4b/amdahl/__main__.py

hpc-carpentry-amdahl-46c9b4b/amdahl/amdahl.py

hpc-carpentry-amdahl-46c9b4b/requirements.txt

hpc-carpentry-amdahl-46c9b4b/setup.pyDa notare che non è stato necessario digitare

-x -v -z -f, grazie alla concatenazione dei flag, anche se

il comando funziona in modo identico in entrambi i casi, purché l’elenco

concatenato termini con f, perché la stringa successiva

deve specificare il nome del file da estrarre.

La cartella ha un nome non adatto, quindi cambiamolo con qualcosa di più comodo.

Controllare la dimensione della directory estratta e confrontarla con

la dimensione del file compresso, usando du per

“disk usage”.

BASH

[you@laptop:~]$ du -sh amdahl.tar.gz

8.0K amdahl.tar.gz

[you@laptop:~]$ du -sh amdahl

48K amdahlI file di testo (compreso il codice sorgente Python) si comprimono bene: il “tarball” è un sesto della dimensione totale dei dati grezzi!

Se si vuole invertire il processo - comprimere i dati grezzi invece

di estrarli - impostare un flag c invece di x,

impostare il nome del file di archivio e fornire una cartella da

comprimere:

OUTPUT

amdahl/

amdahl/.github/